Proxmox VE 8.1 の環境を構築する

Published on 2024/01/23 , Last updated 2025/08/19Tags

概要

Proxmox VE 8.1 の環境を構築します。

環境

ハードウェア

- ベアボーン: ASRock DeskMeet X300

- CPU: AMD Ryzen 7 5700G

- Memory: SanMax DDR4-3200 32GB x4

- Storage: SAMSUNG 970 EVO Plus 2TB

- Network: Anker PowerExpand USB-C & 2.5Gbps イーサネットアダプタ

- GPU: NVIDIA RTX 4000 SFF Ada

ソフトウェア

- Proxmox VE 8.1

- Rufus 4.3

前提条件

- ブータブル USB メモリ用の USB メモリが必要です。

- ブータブル USB メモリを作成するための Windows マシンガ必要です。

Proxmox VE の環境構築

インストーラーのダウンロード

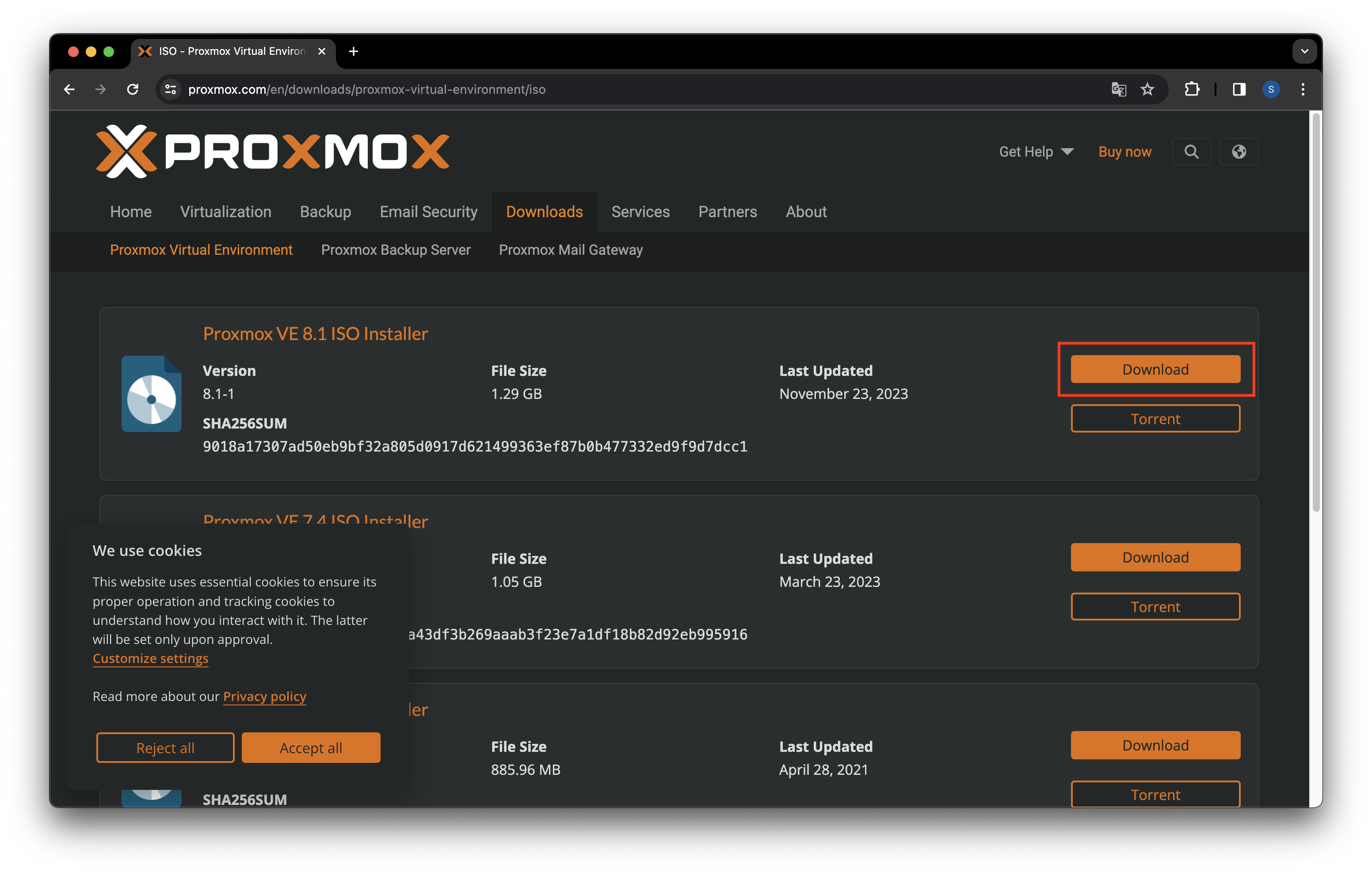

Proxmox VE の ISO インストーラーをダウンロードします。

-

インストーラーの ダウロードサイト を開きます。

-

Proxmox VE 8.1 ISO Installerの Download ボタンを押下します。

ブータブル USB メモリの作成

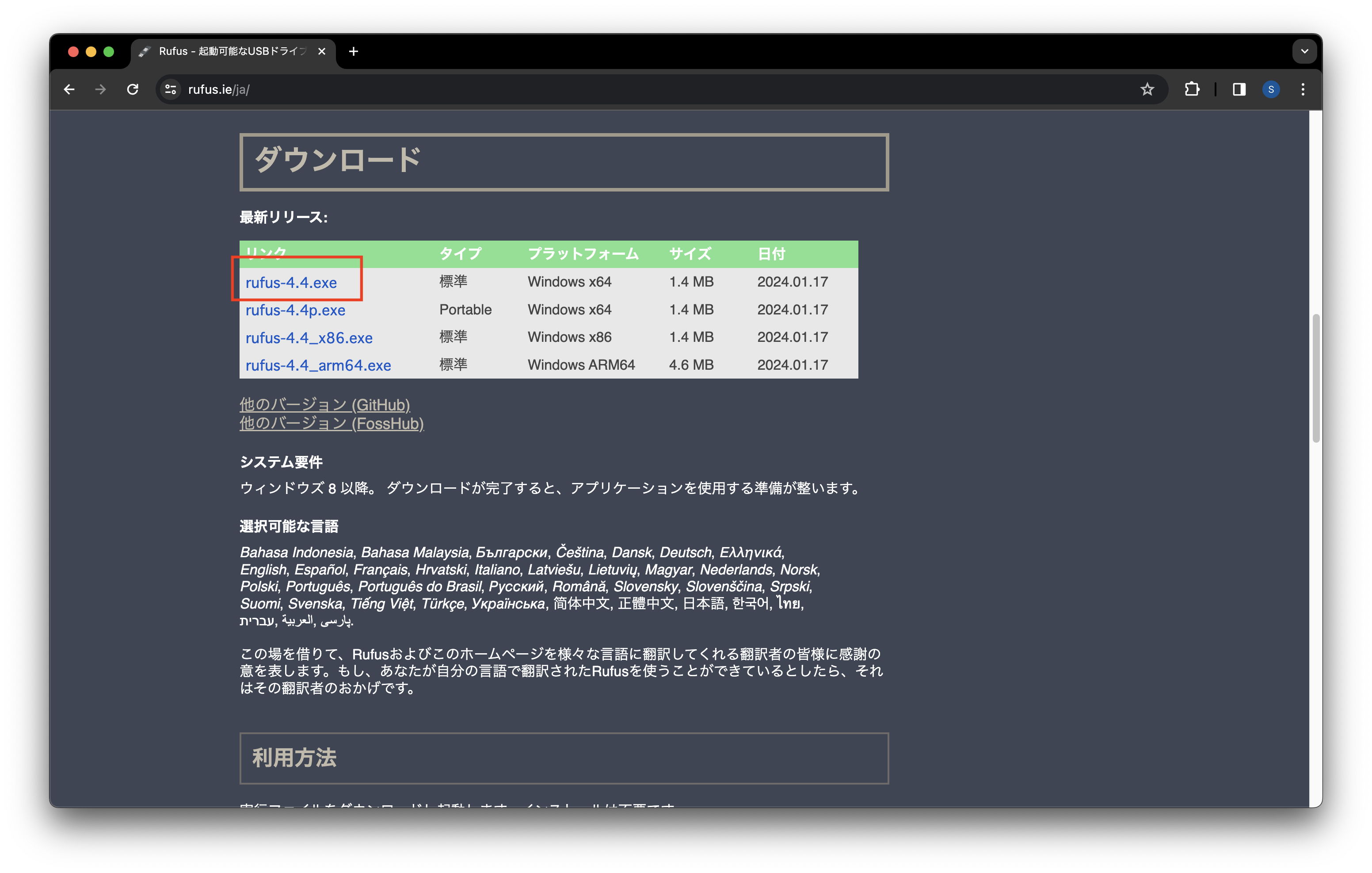

Rufus を使用して Proxmox VE をインストールするためのブータブル USB メモリの作成を作成します。

-

Rufus を開きます。

-

ダウンロードから exe ファイルのリンクを選択して Rufus をダウロードします。

-

ダウンロードした Rufus を起動します。

-

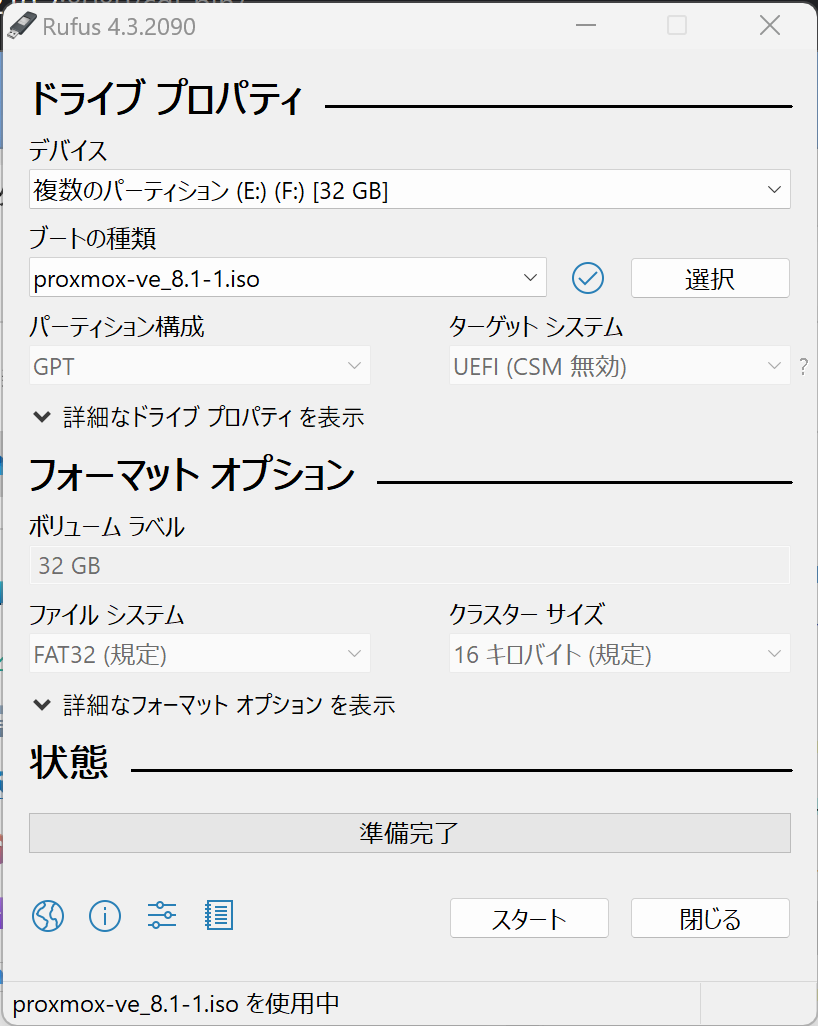

ドライブプロパティを設定します。

- デバイス: USB メモリを選択します。

- ブートの種類:

選択ボタンを押下して Proxmox VE の ISO インストーラーを選択します。

-

スタートボタンを押下してブータブル USB メモリの作成を開始します。

Proxmox VE のインストール

注意事項

- Secure Boot を無効にする必要があります。

- グラフィックボードが刺さった状態だとインストールに失敗したので抜く必要があるようです。

-

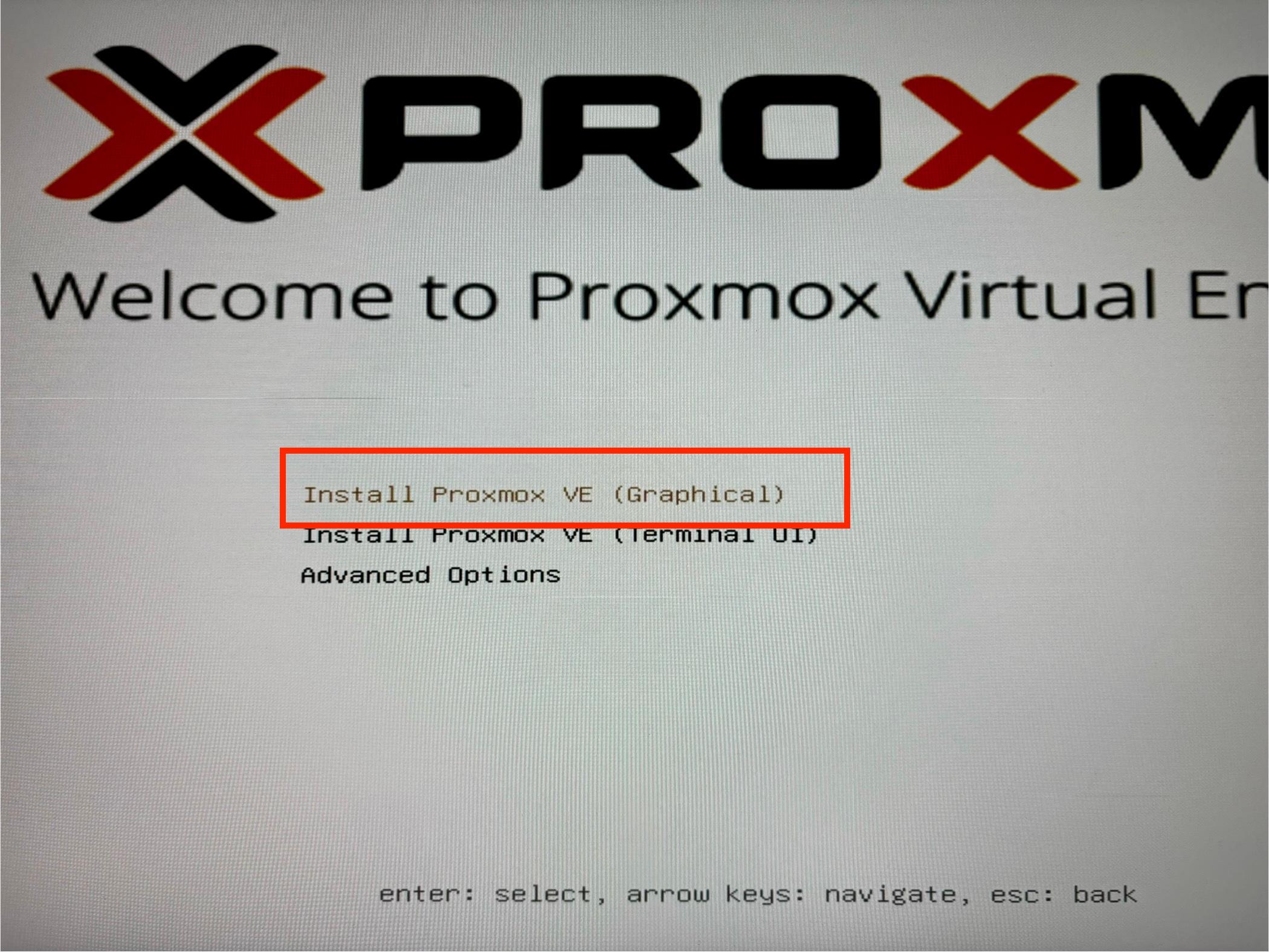

Proxmox VE をインストールするマシンにブータブル USB メモリを挿します。

-

マシンの電源を入れて UEFI を開き、ブータブル USB メモリからブートするように設定し再起動ます。

-

Proxmox VE の インストーラーが起動したら

Install Proxmox VE (Graphical)を選択しインストールを開始します。

-

I Agreeボタンを押下してライセンスに同意します。

-

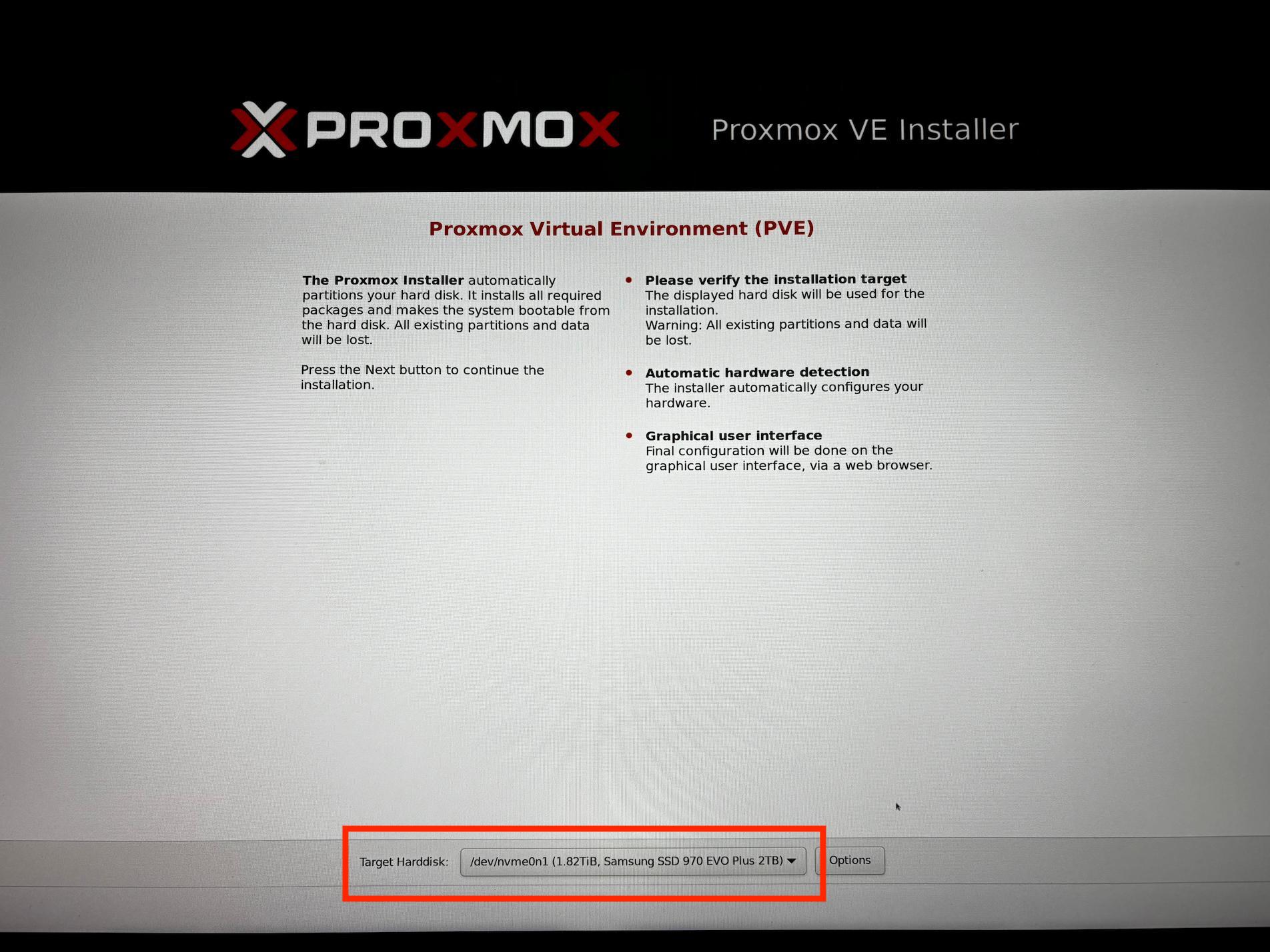

Proxmox VE をインストールするドライブを選択して

Nextボタンを押下します。

-

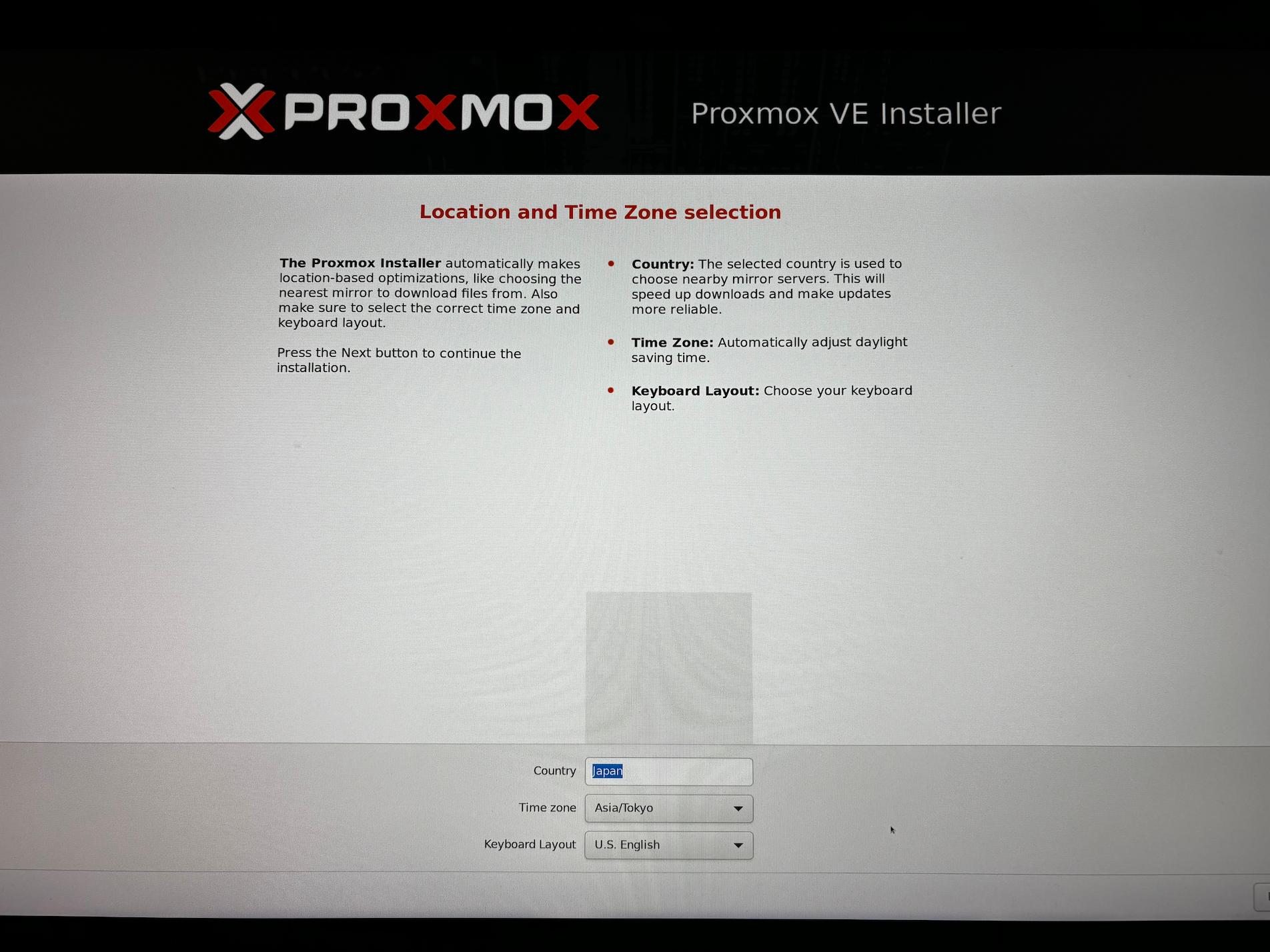

国、タイムゾーン、キーボードレイアウトを選択して

Nextボタンを押下します。

-

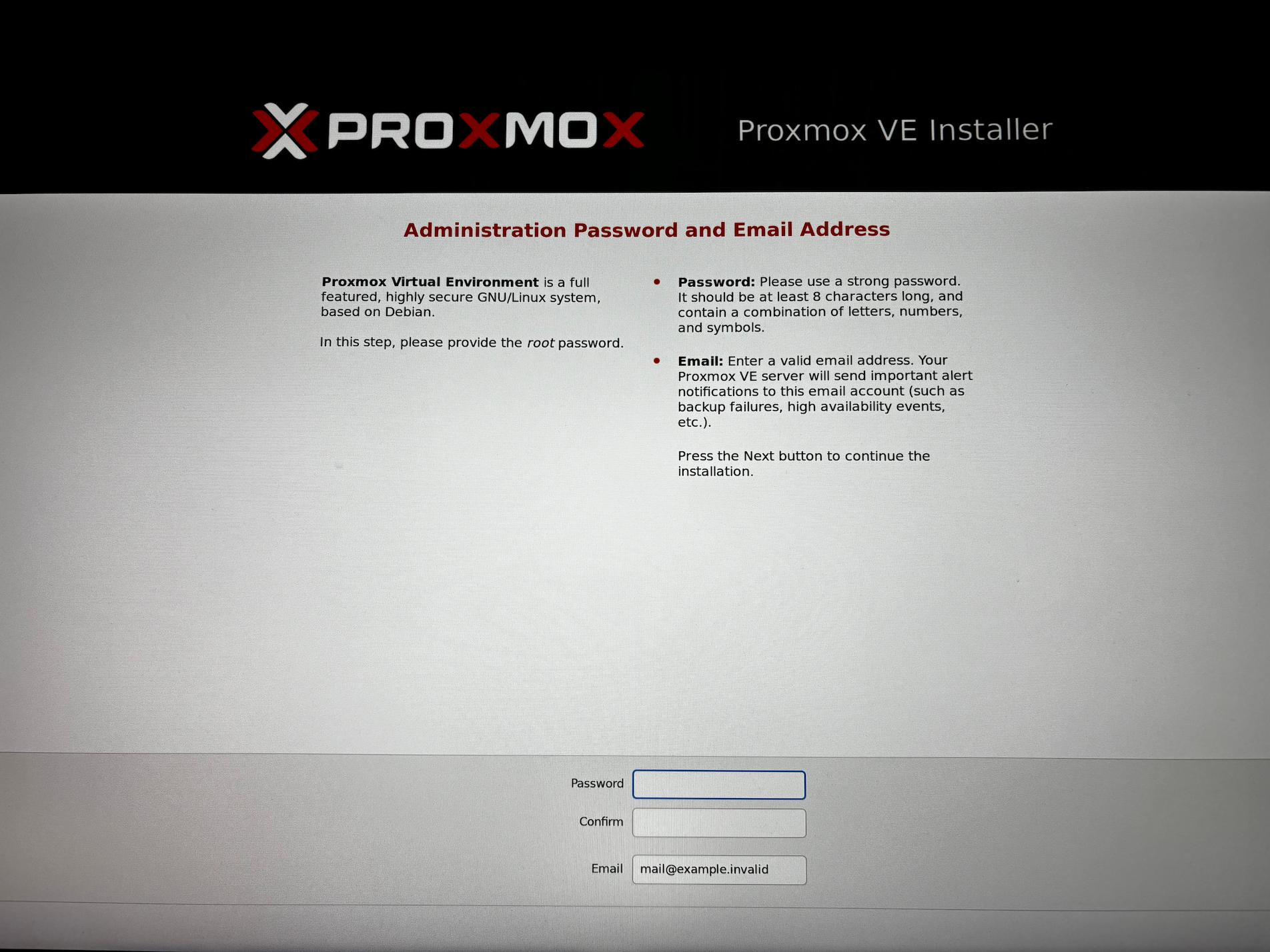

パスワード、メールアドレスを入力して

Nextボタンを押下します。

-

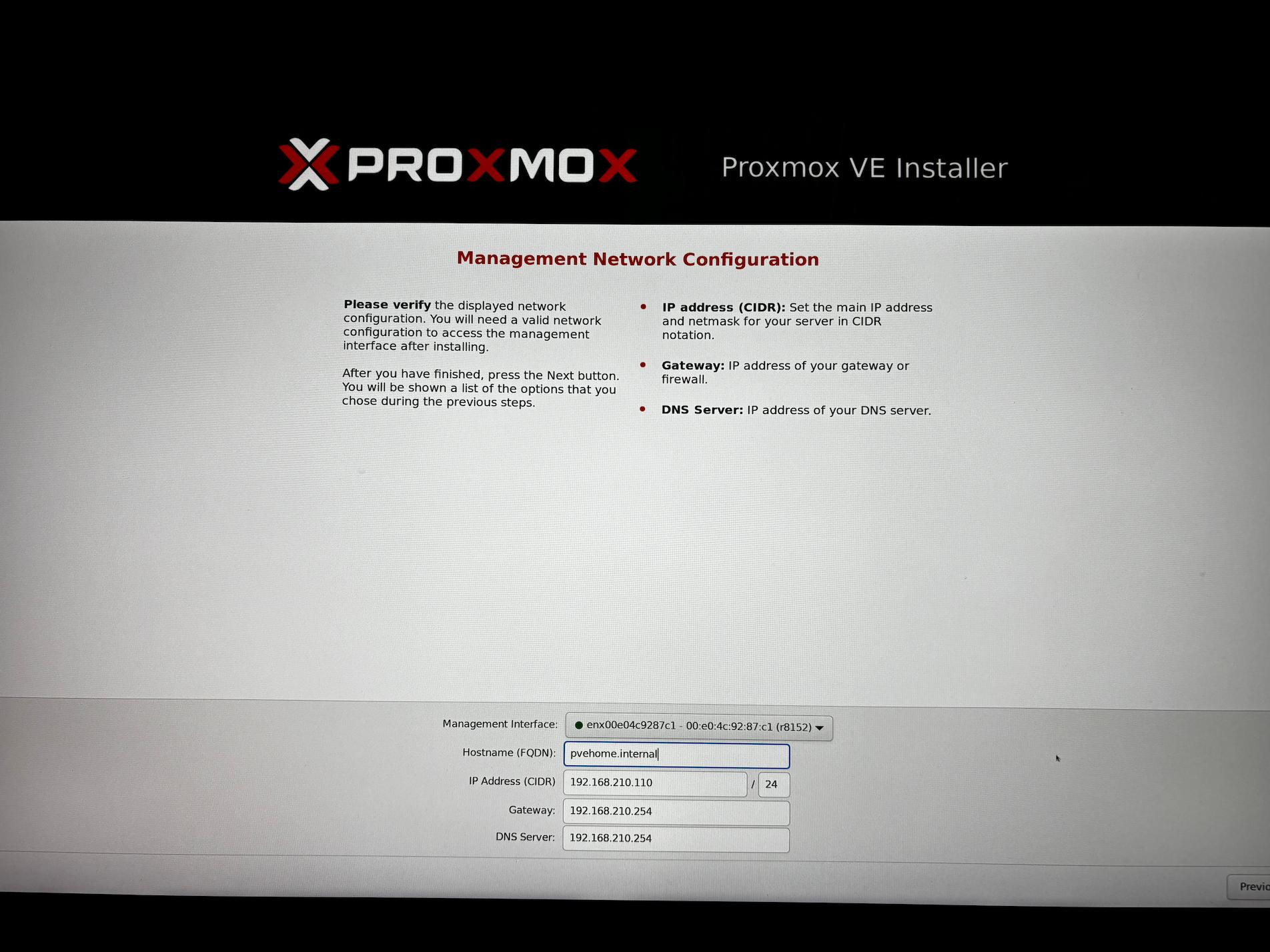

ネットワークの設定を行い

Nextボタンを押下します。

- Management Interface: 使用するイーサネットアダプタを選択します。

- Hostname (FQDN): 任意の FQDN を入力します。

- IP Address (CIDR): 任意のアドレスを入力します。

- Gateway: ルーターのアドレスを入力します。

- DNS Server: ルーターのアドレスを入力します。

-

Summary 画面で問題なければインストールを開始します。

-

インストールが完了したら管理画面にアクセスするための URL が表示されます。

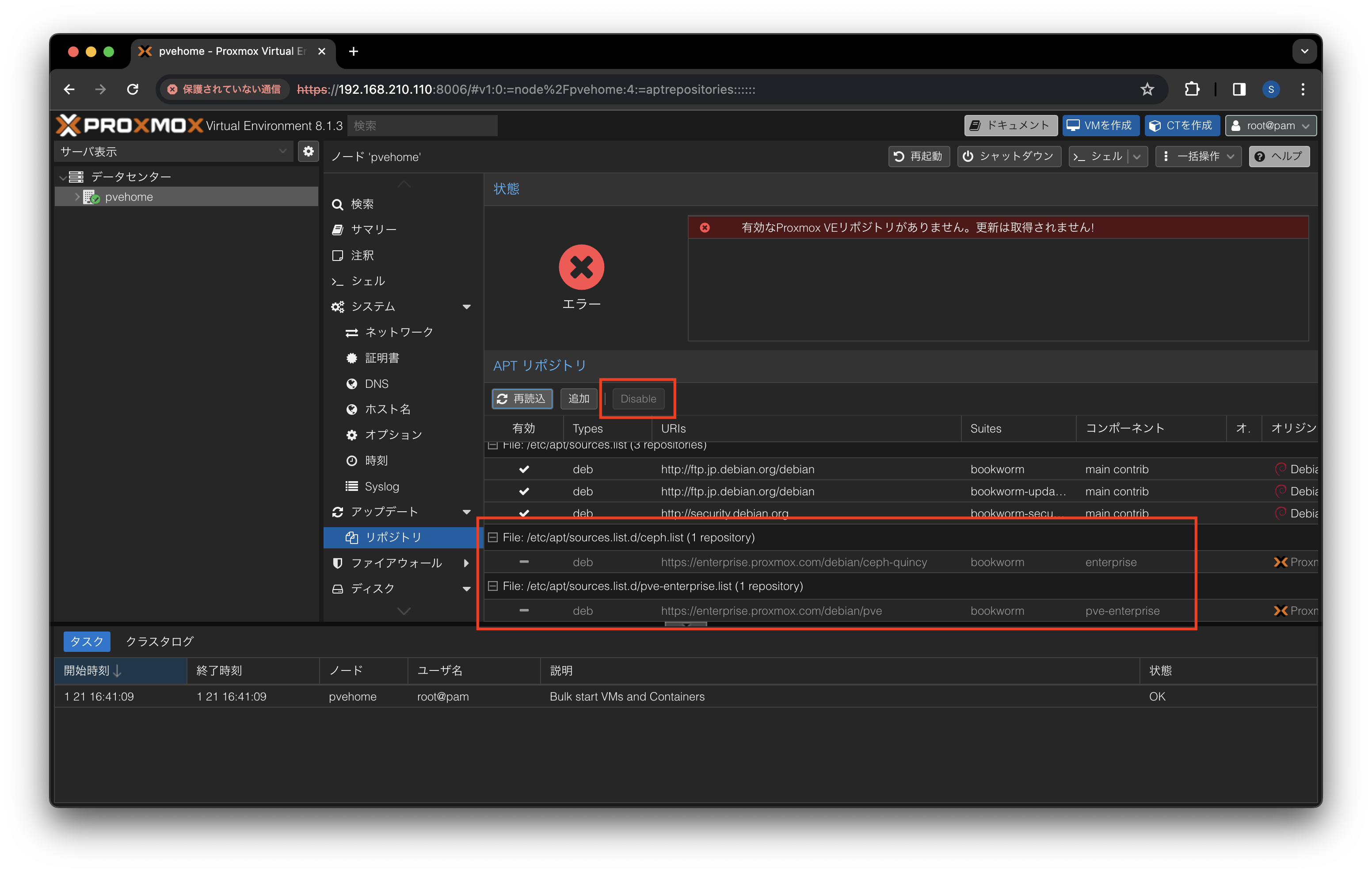

Enterprise リポジトリの無効化

アップデートの参照先リポジトリが Enterprise リポジトリになっているので無効にします。

-

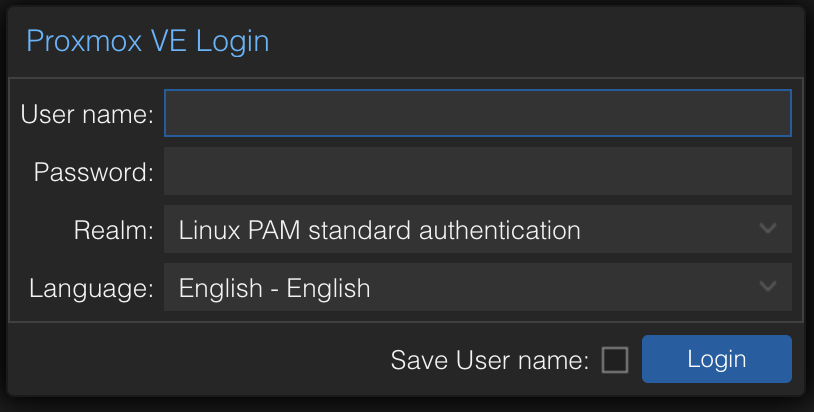

管理画面の URL を開きます。

-

Login ダイアログでパスワードの入力と言語を選択しログインします。

-

アップデート > リポジトリ から Enterprise リポジトリを選択し

Disableボタンを押下します。

-

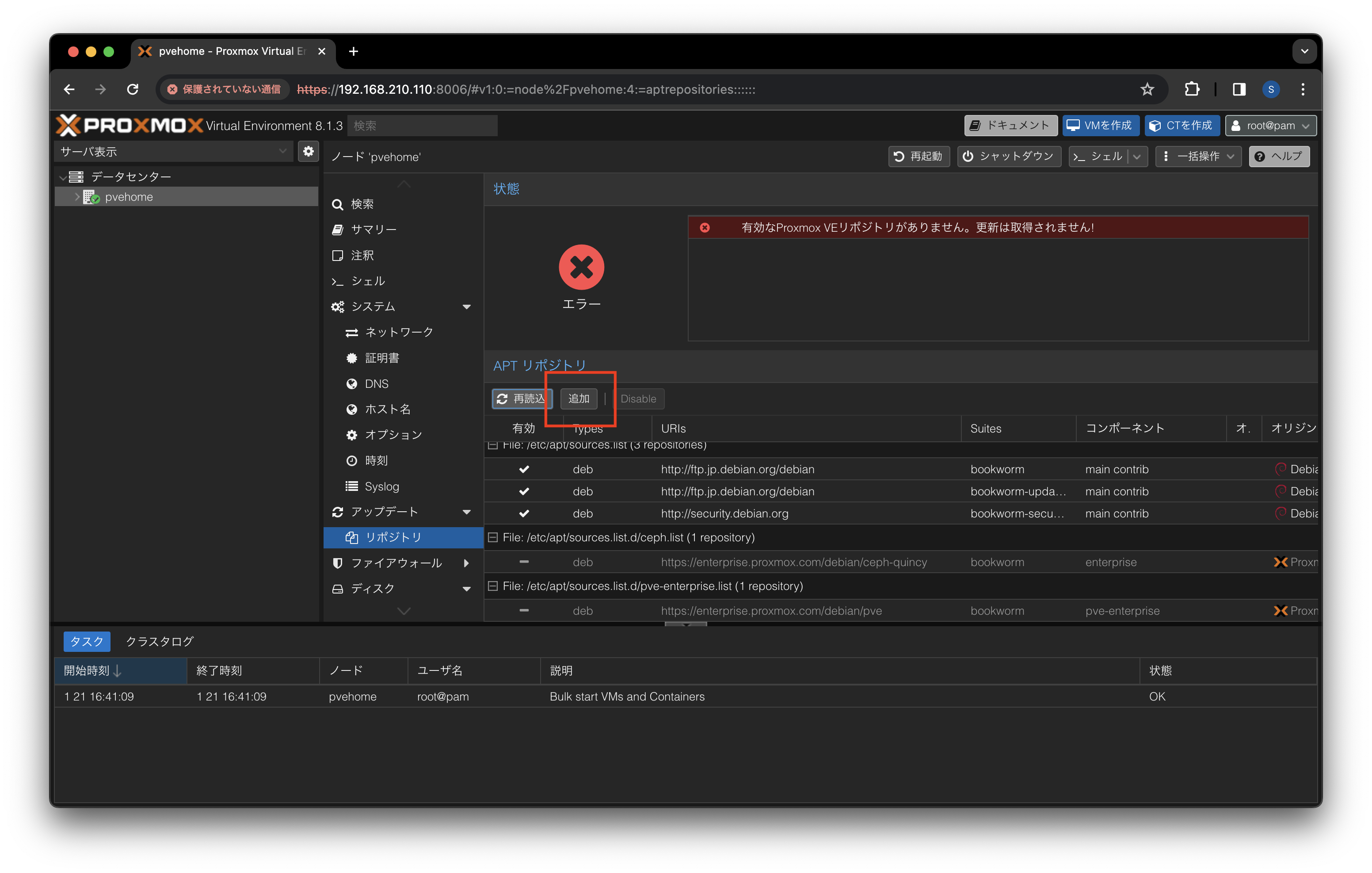

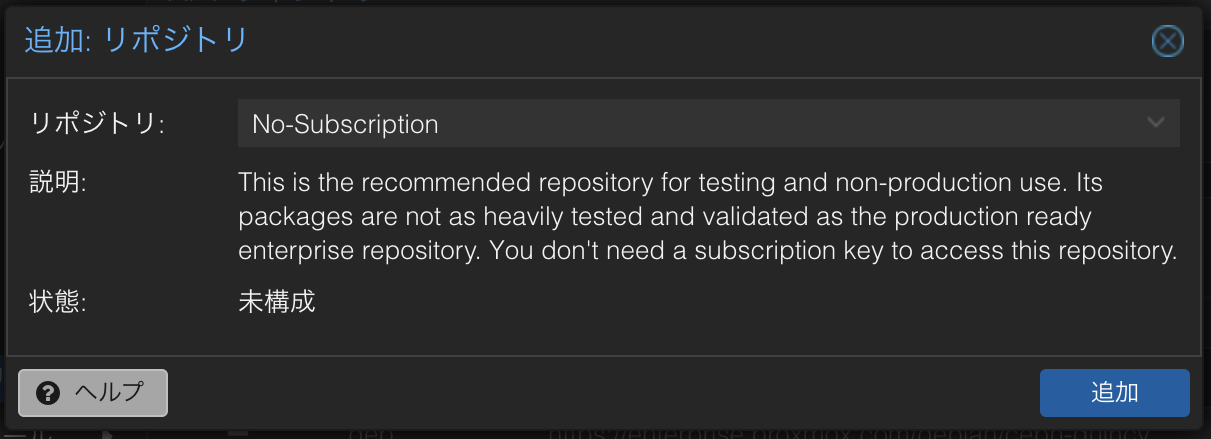

追加ボタンを押下してリポジトリの追加ダイアログを開きます。

-

リポジトリ

No-Subscriptionを選択し追加ボタンを押下します。

-

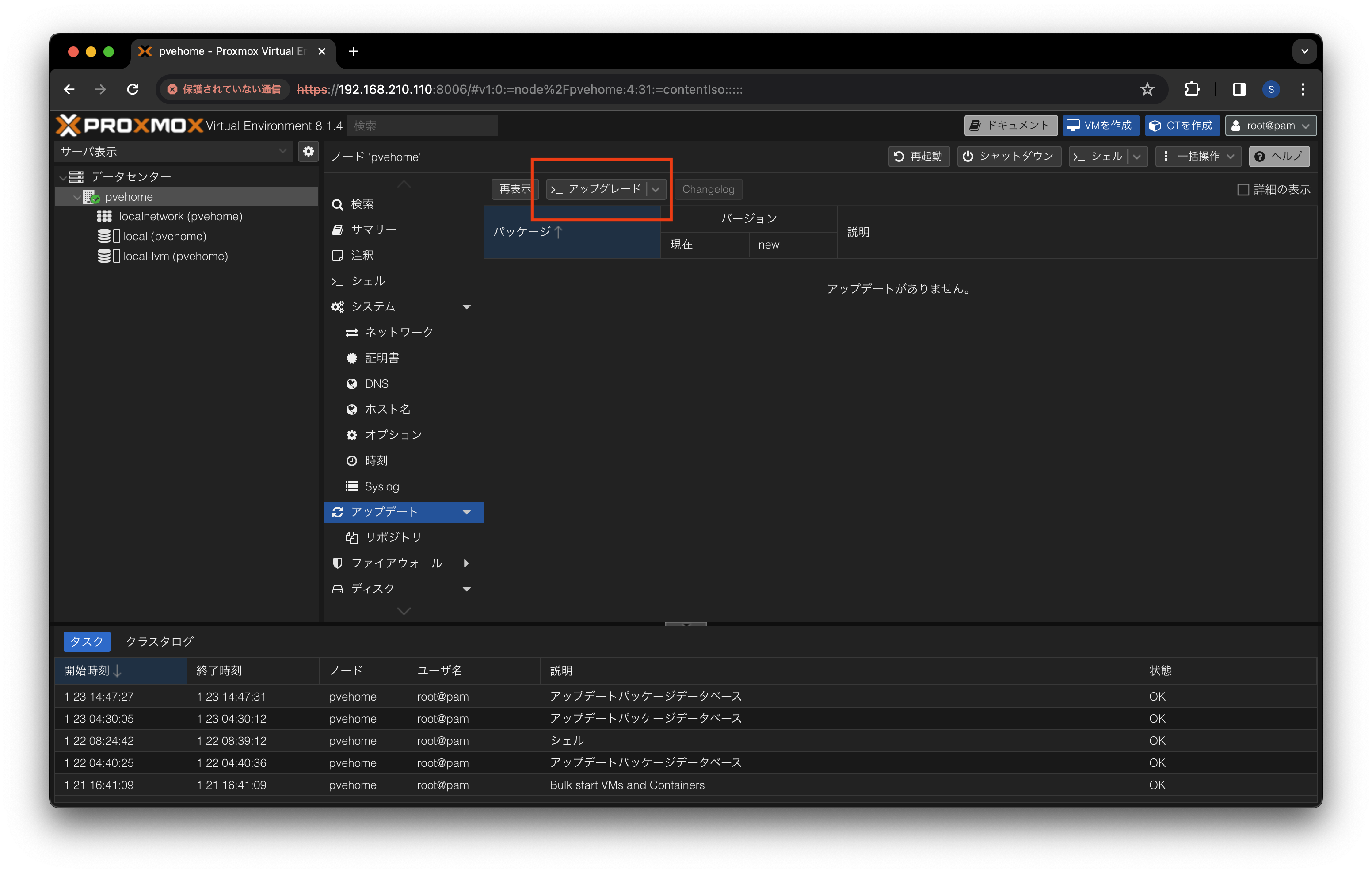

アップデートの

>_ アップグレードボタンを押下します。

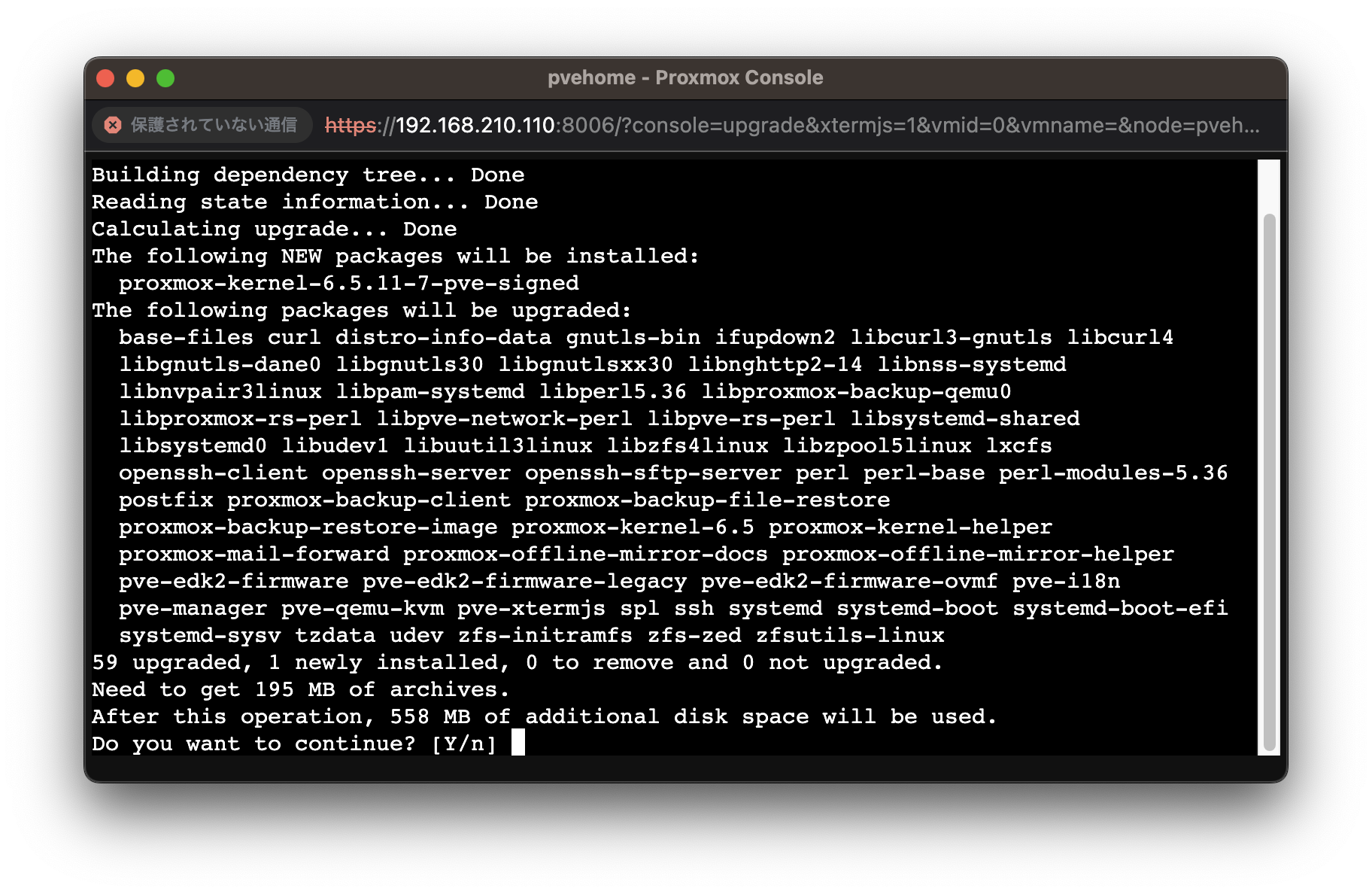

-

アップグレードを実行します。

VM (仮想マシン) の構築

Windows 11 の VM を構築します。

インストーラーのダウンロード

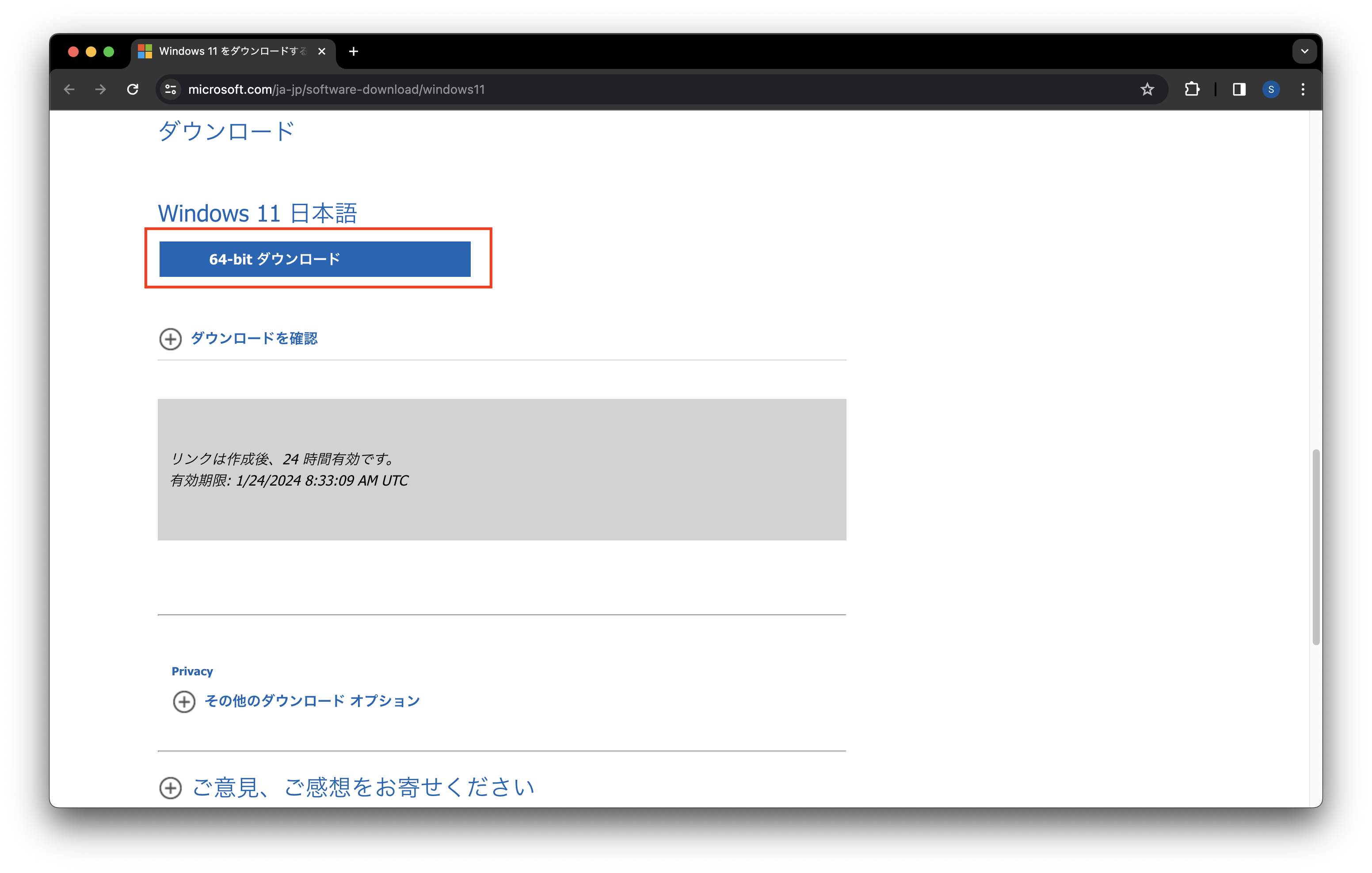

Windows 11 の ISO インストーラーをダウンロードします。

-

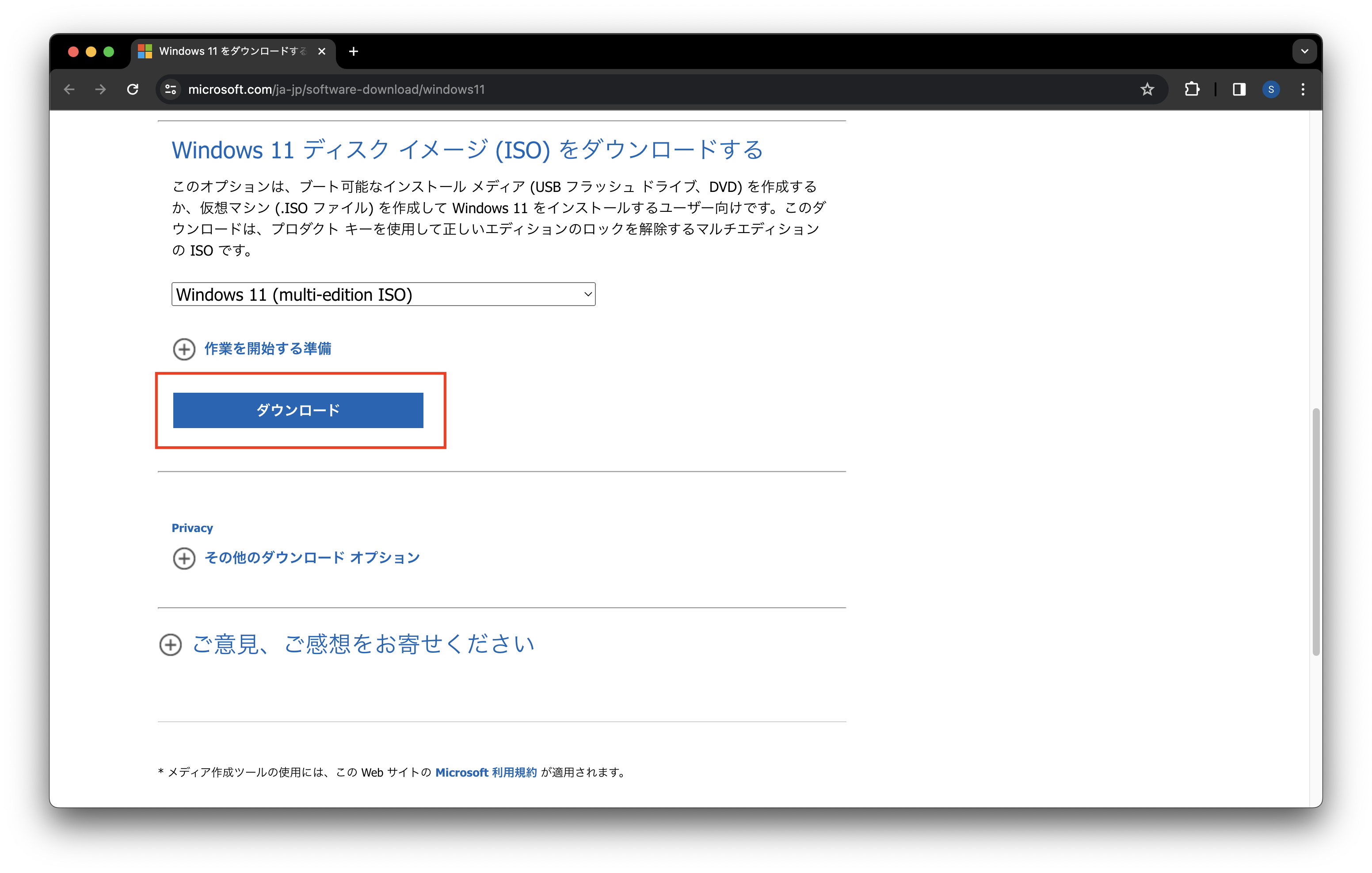

Windows 11 の ダウンロードサイト を開き

Windows 11 ディスク イメージ (ISO) をダウンロードするに移動します。 -

ダウンロードを選択 を

Windows 11 (multi-edition ISO)に変更してダウンロードボタンを押下します。

-

製品の言語の選択 を

日本語に変更して確認ボタンを押下します。

-

64-bit ダウンロードボタンを押下してダウンロードを開始します。

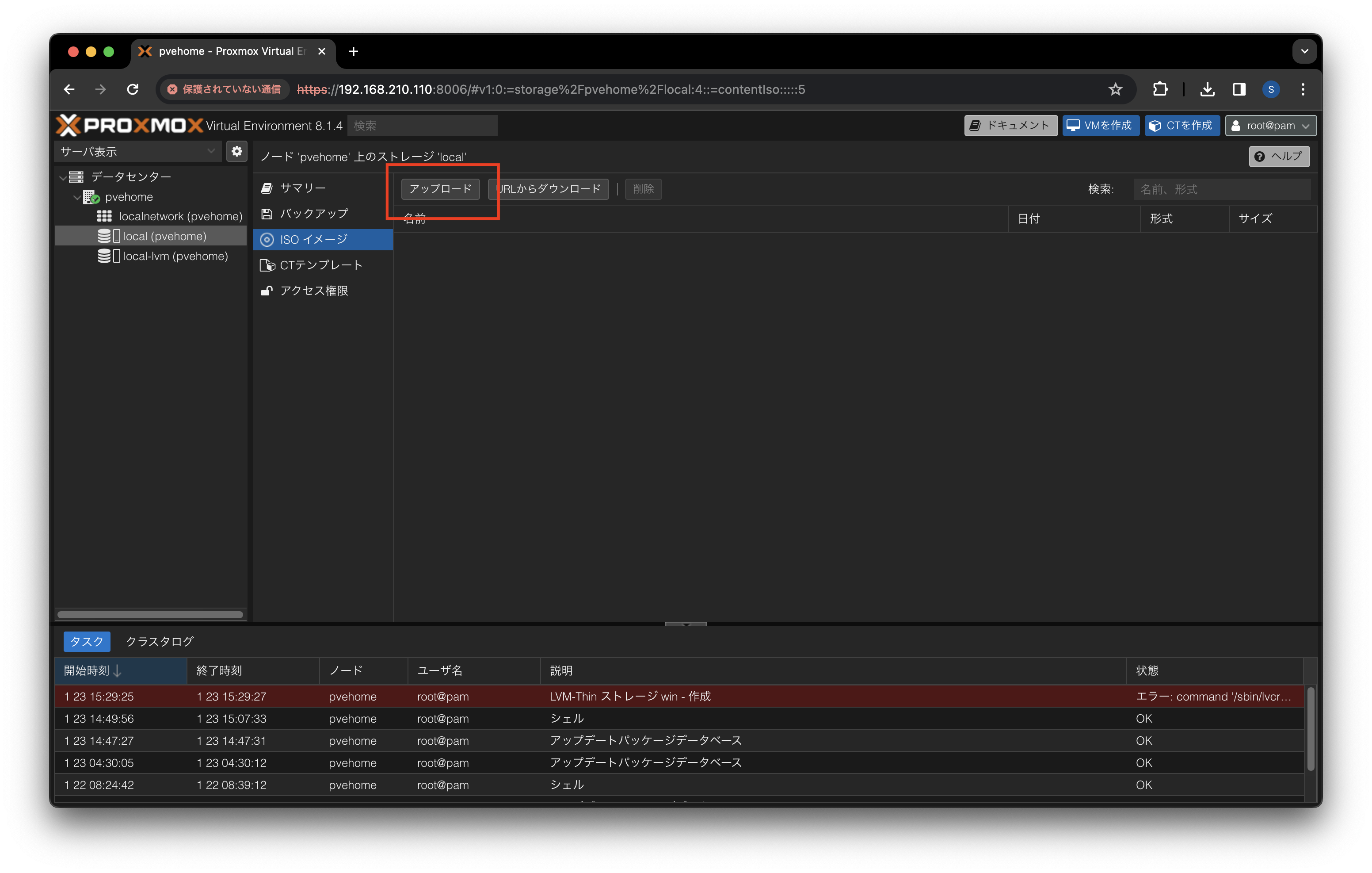

インストーラーのアップロード

Windows 11 の ISO インストーラーを Proxmox VE のストレージにアップロードします。

-

Proxmox VE の管理画面を開きます。

-

データセンター > local > ISO イメージ を開き

アップロードボタンを押下します。

-

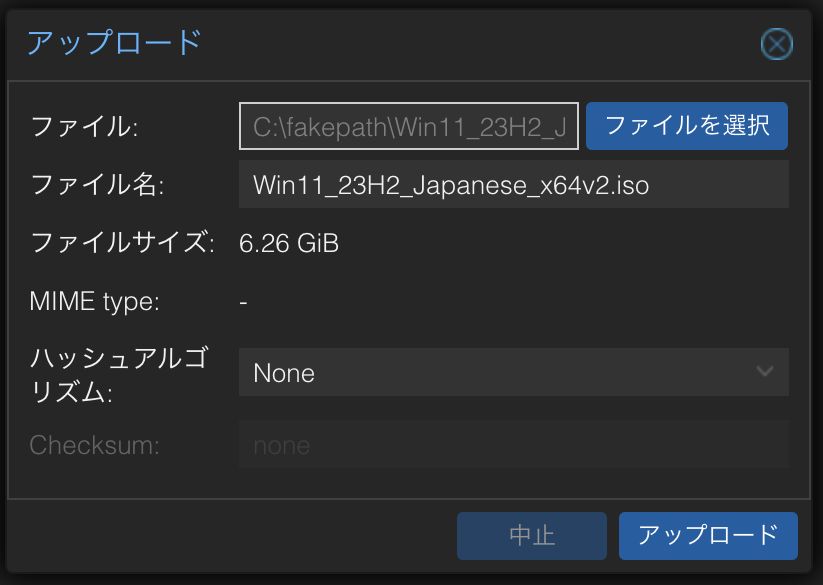

アップロードダイアログで

ファイルを選択からダウンロードした ISO ファイルを選択しアップロードボタンを押下します。

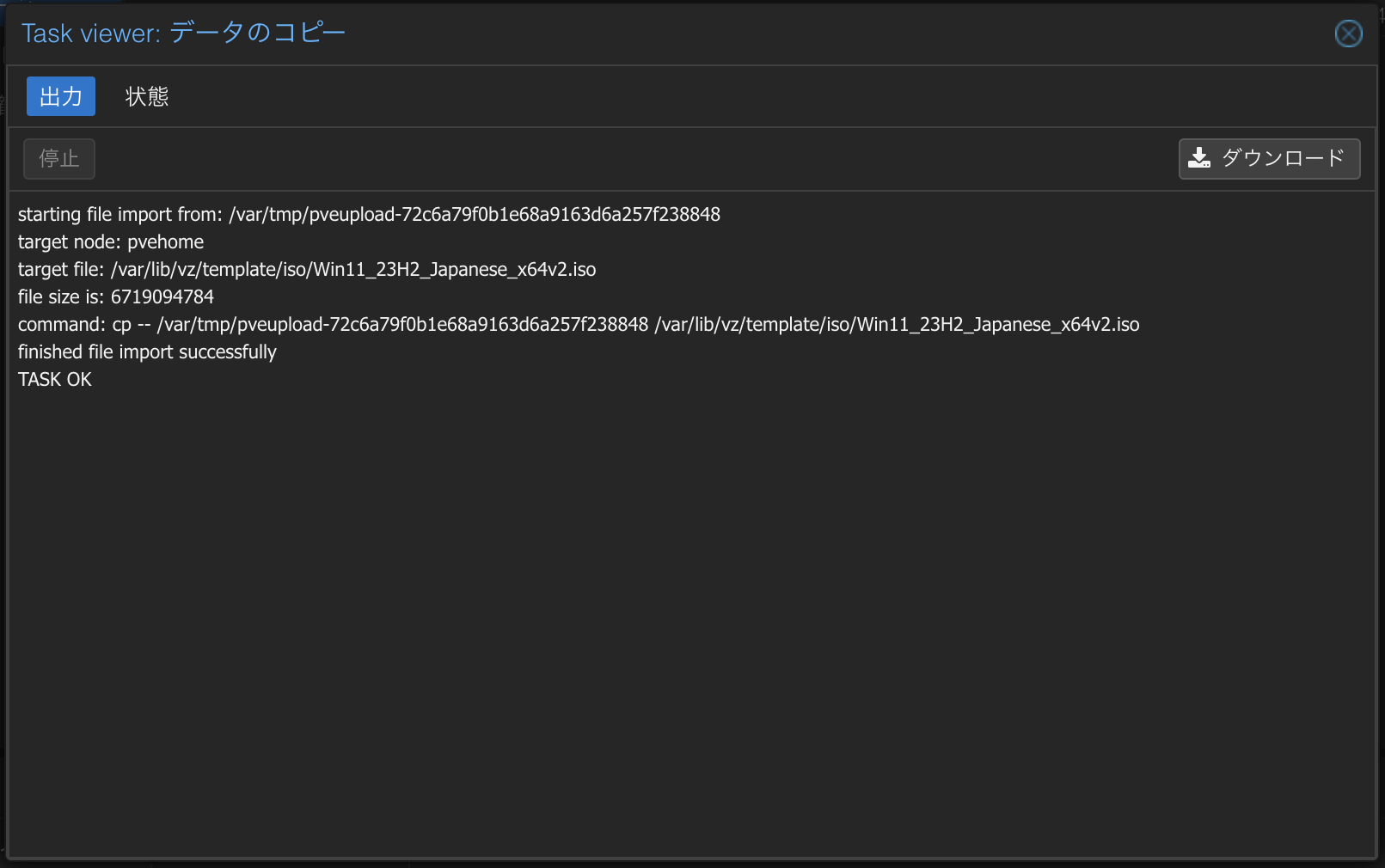

-

アップロードが完了したら Task viewer を閉じます。

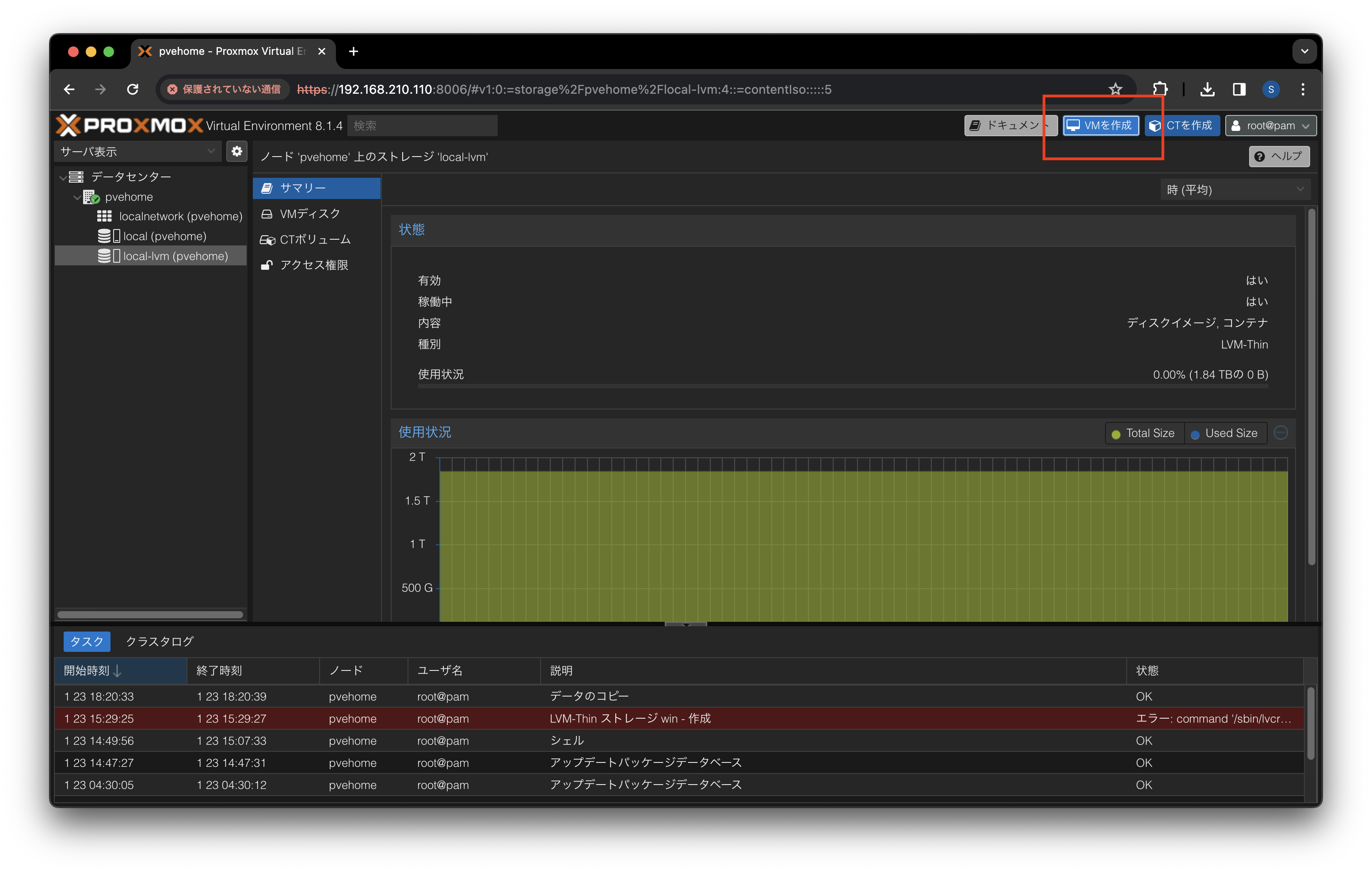

VM の作成

Windows 11 の VM を作成します。

-

Proxmox VE の管理画面を開きます。

-

データセンター > local-lvm を開き

VMを作成ボタンを押下します。

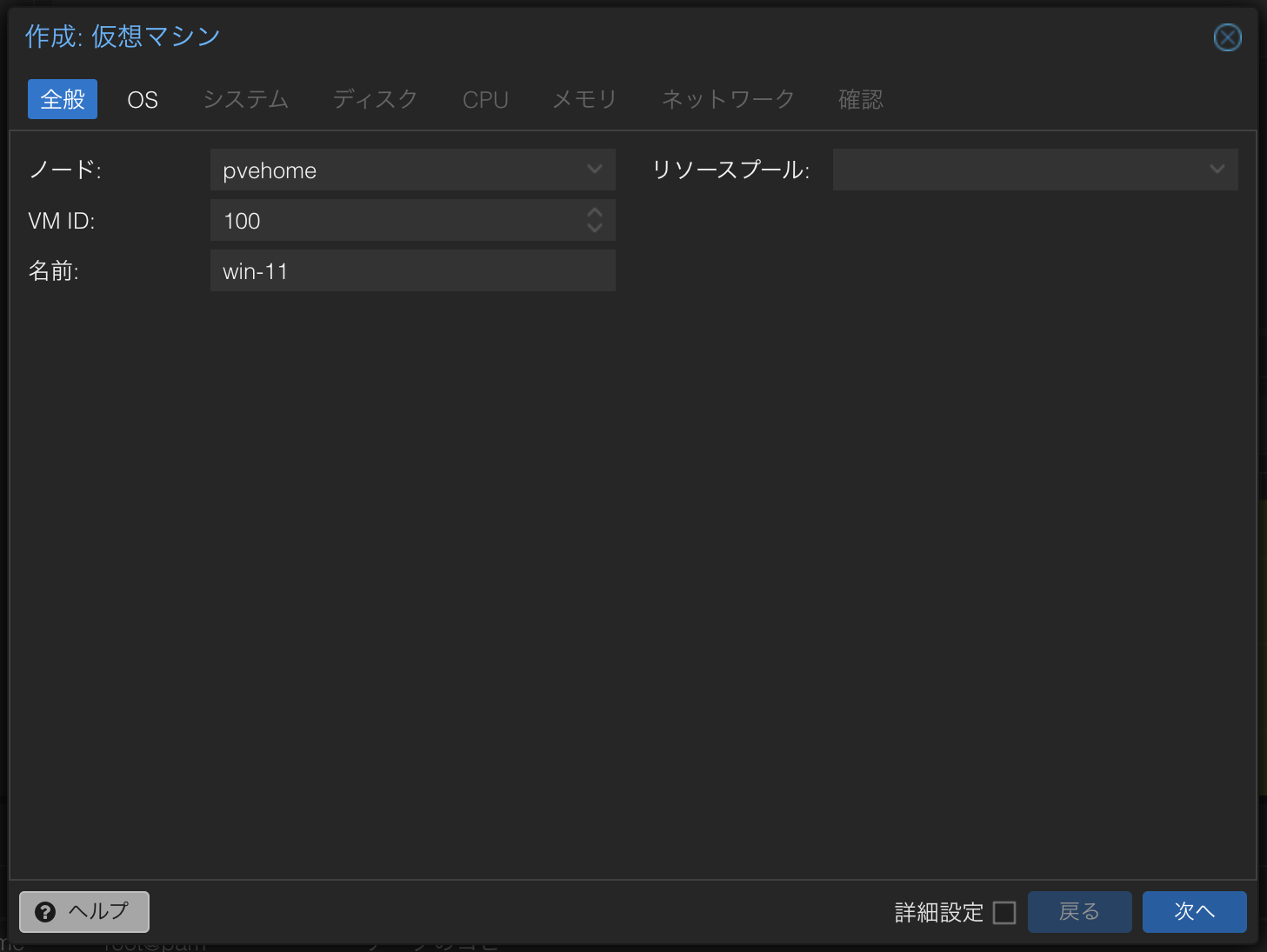

-

全般の情報を入力して

次へボタンを押下します。

- 名前: 仮想マシンの名前を入力します。

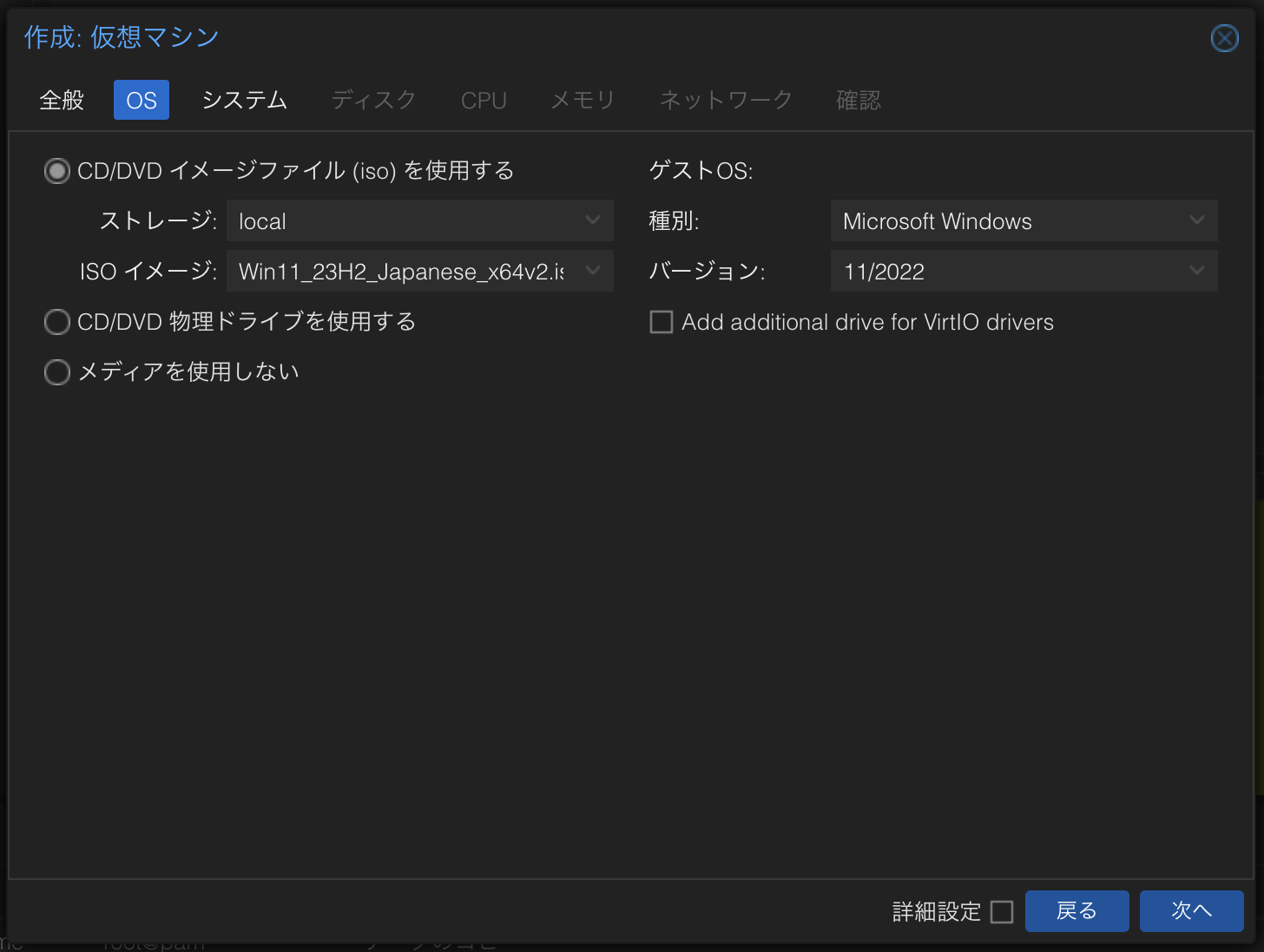

-

OS の情報を入力して

次へボタンを押下します。

- CD/DVD イメージファイル (iso) を使用する

- ISO イメージ: Windows 11 の ISO ファイルを選択します。

- ゲスト OS

- 種類:

Microsoft Windowsを選択します。 - バージョン:

11/2022を選択します。

- 種類:

- CD/DVD イメージファイル (iso) を使用する

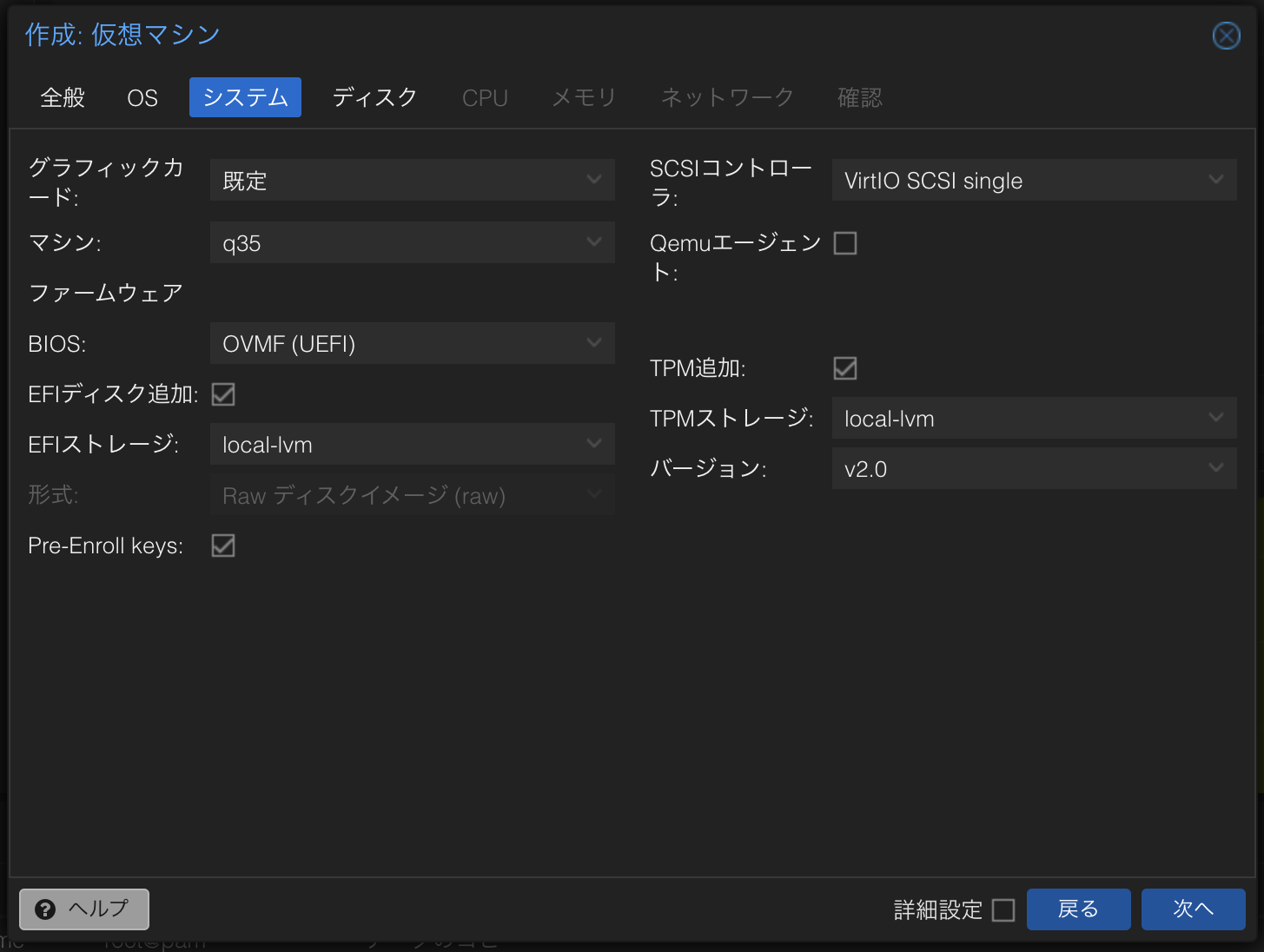

-

システム の情報を入力して

次へボタンを押下します。

- EFI ストレージ:

local-lvmを選択します。 - TPM ストレージ:

local-lvmを選択します。

- EFI ストレージ:

-

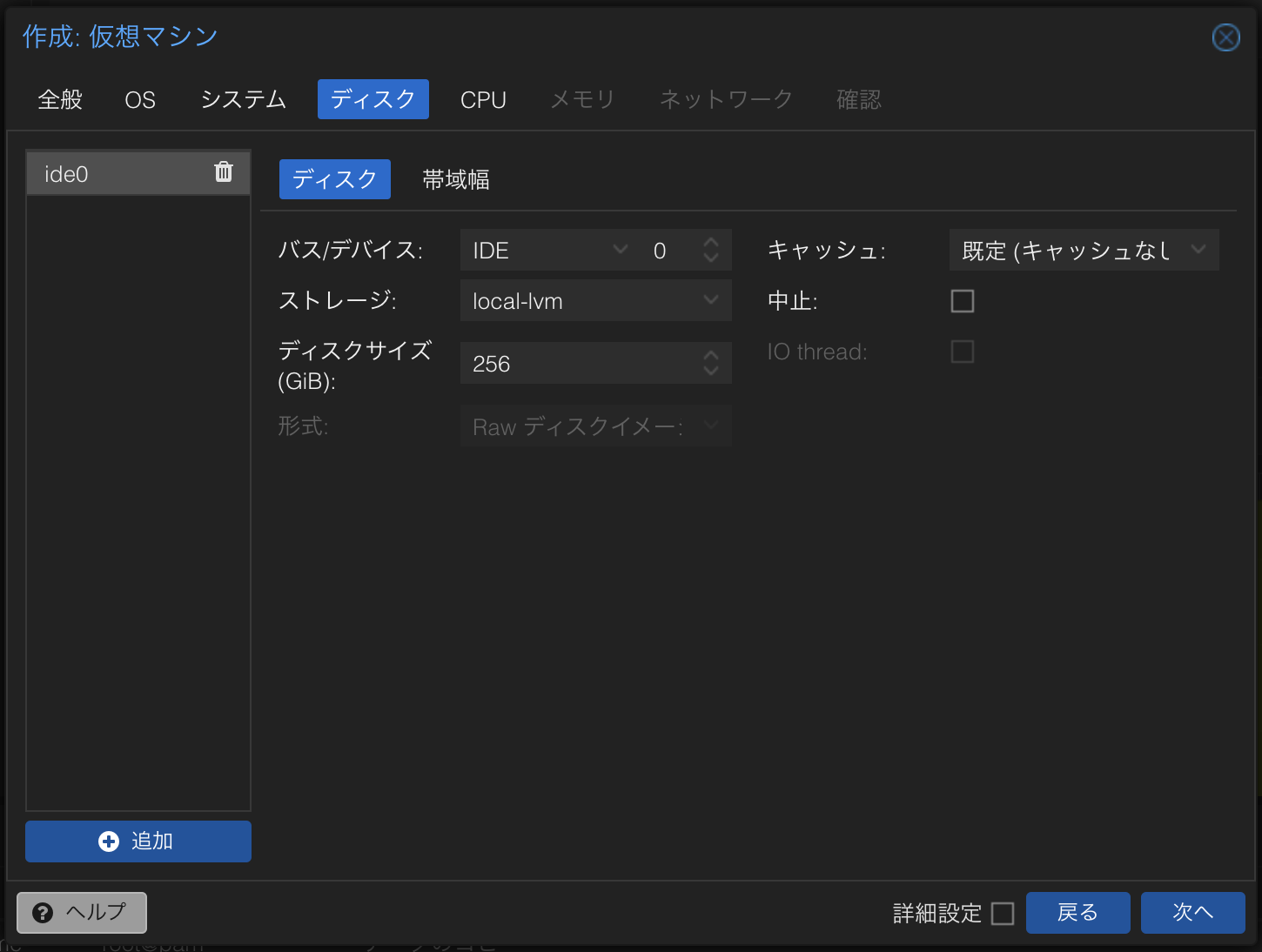

ディスク の情報を入力して

次へボタンを押下します。

- ディスクサイズ (GiB): 任意のサイズを入力します。

-

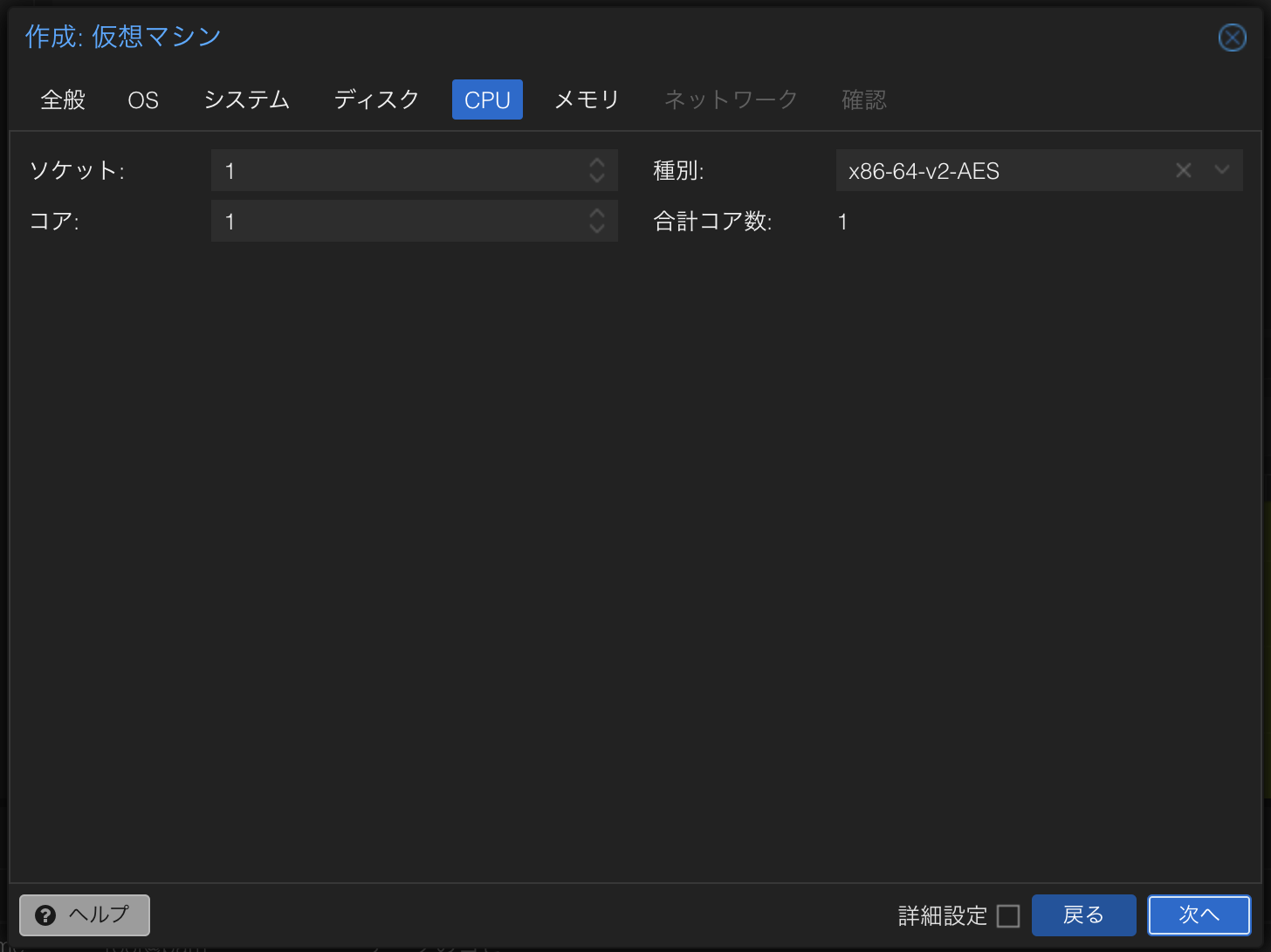

CPU の情報を入力して

次へボタンを押下します。

- コア: 任意のコア数を入力します。

-

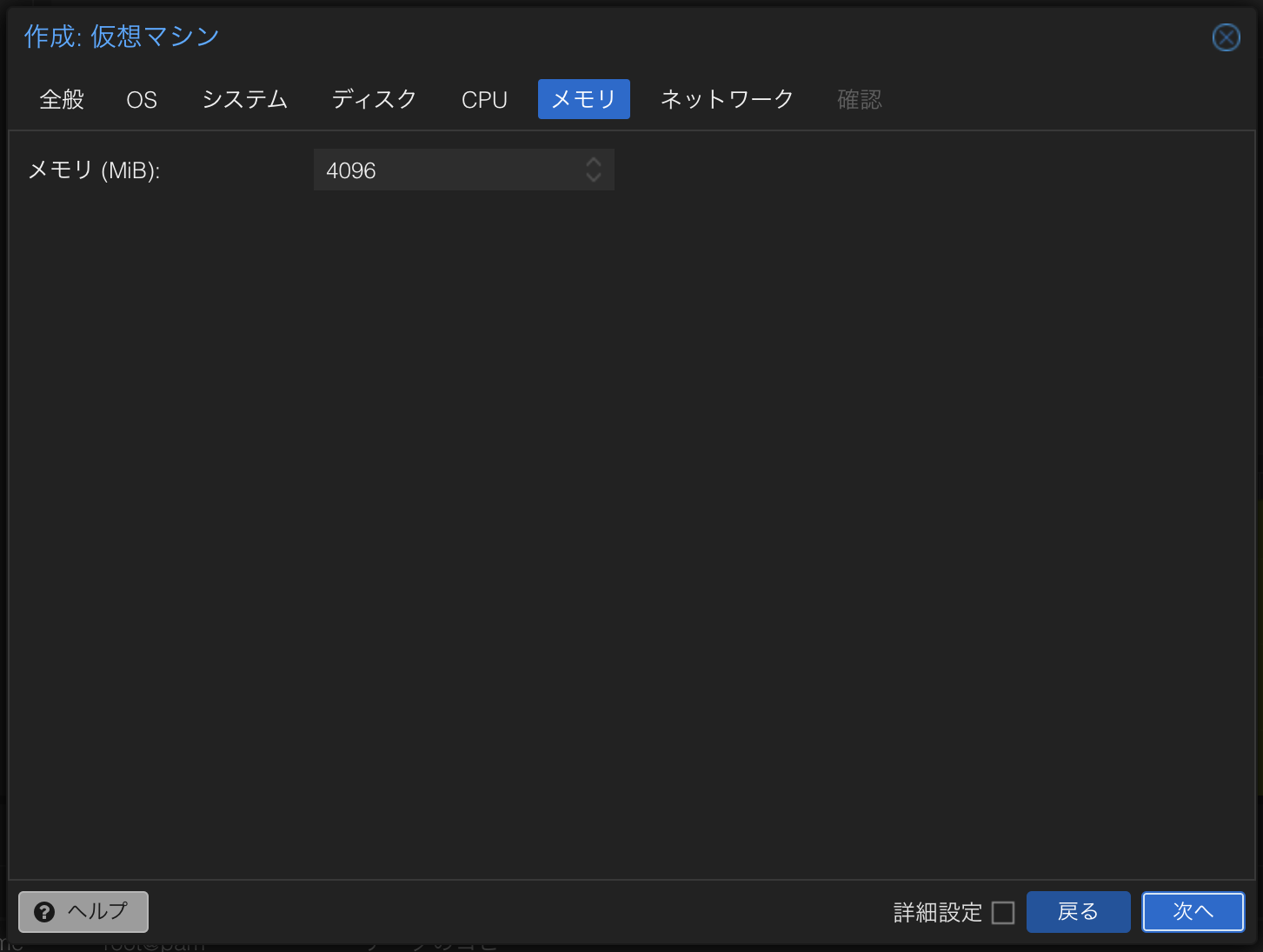

メモリ の情報を入力して

次へボタンを押下します。

- メモリ (MiB): 任意のメモリ容量を入力します。

-

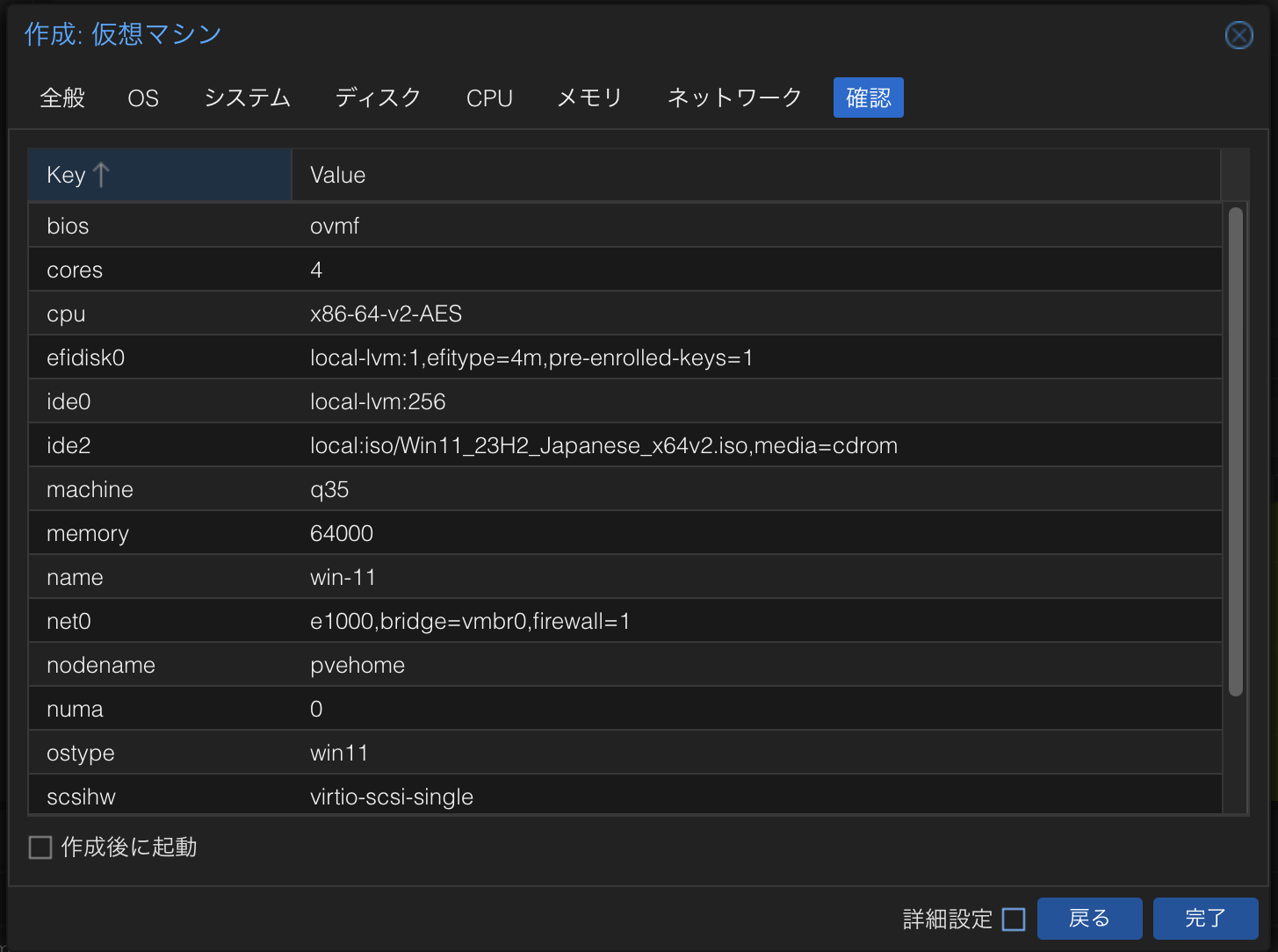

確認 で問題なければ

完了ボタンを押下します。

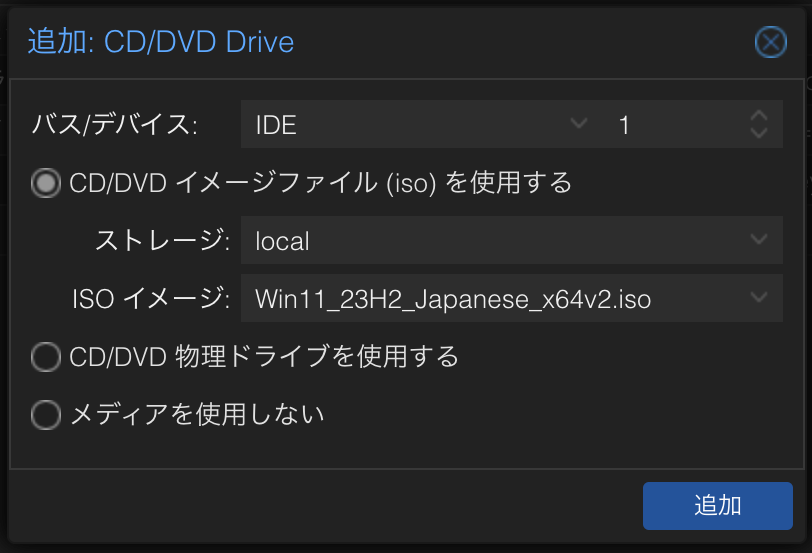

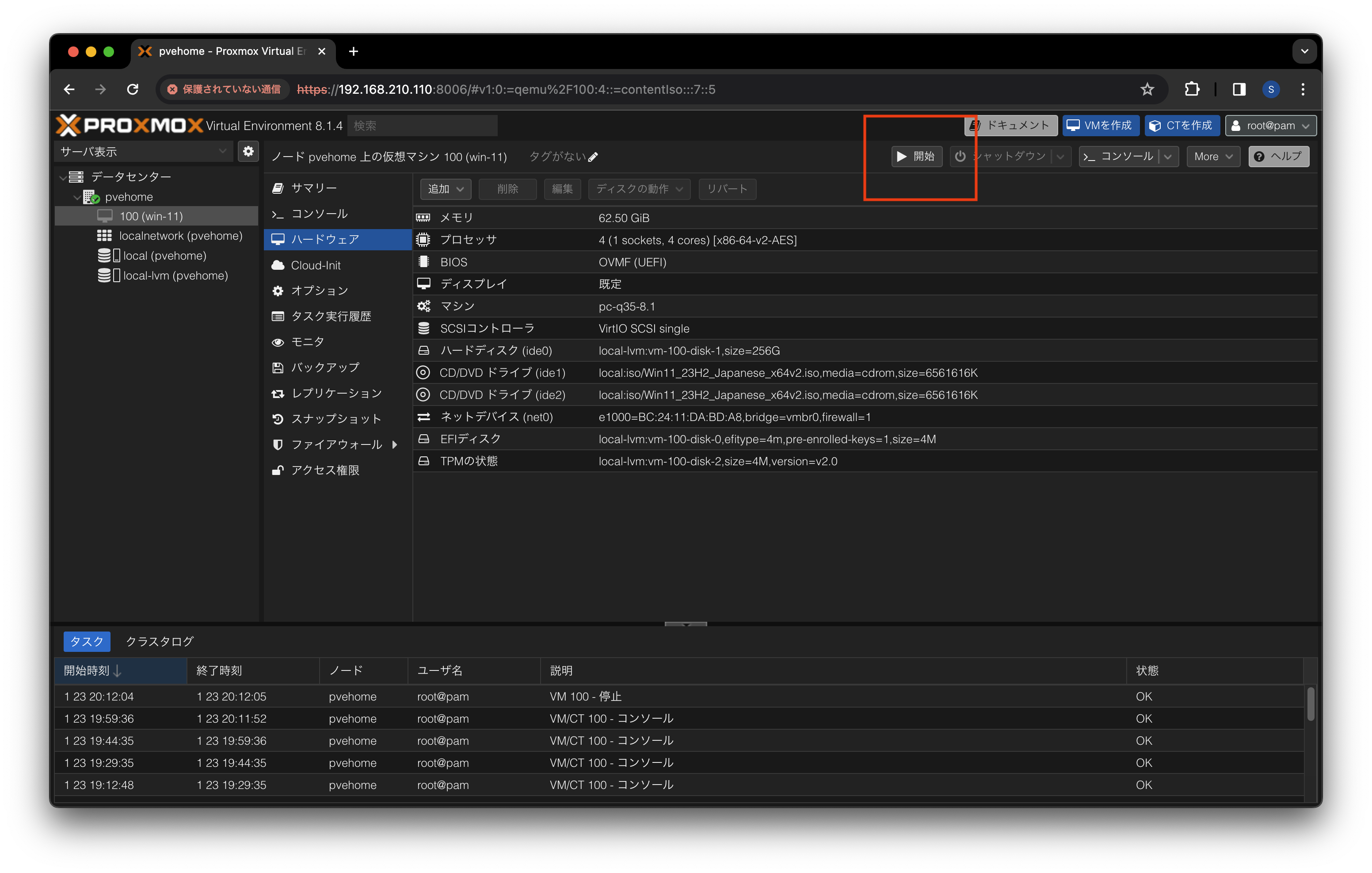

VM の起動

Windows 11 の VM を起動します。

-

Proxmox VE の管理画面を開きます。

-

データセンター > 100 (win-11) > ハードウェア から

CD/DVD ドライブを選択します。

-

CD/DVD Drive ダイアログで ISO イメージを選択し

追加ボタンを押下します。

- CD/DVD イメージファイル (iso) を使用する

- ストレージ:

localを選択します。 - ISO イメージ: Windows 11 の ISO ファイルを選択します。

- ストレージ:

- CD/DVD イメージファイル (iso) を使用する

-

データセンター > 100 (win-11) から

開始ボタンを押下します。

-

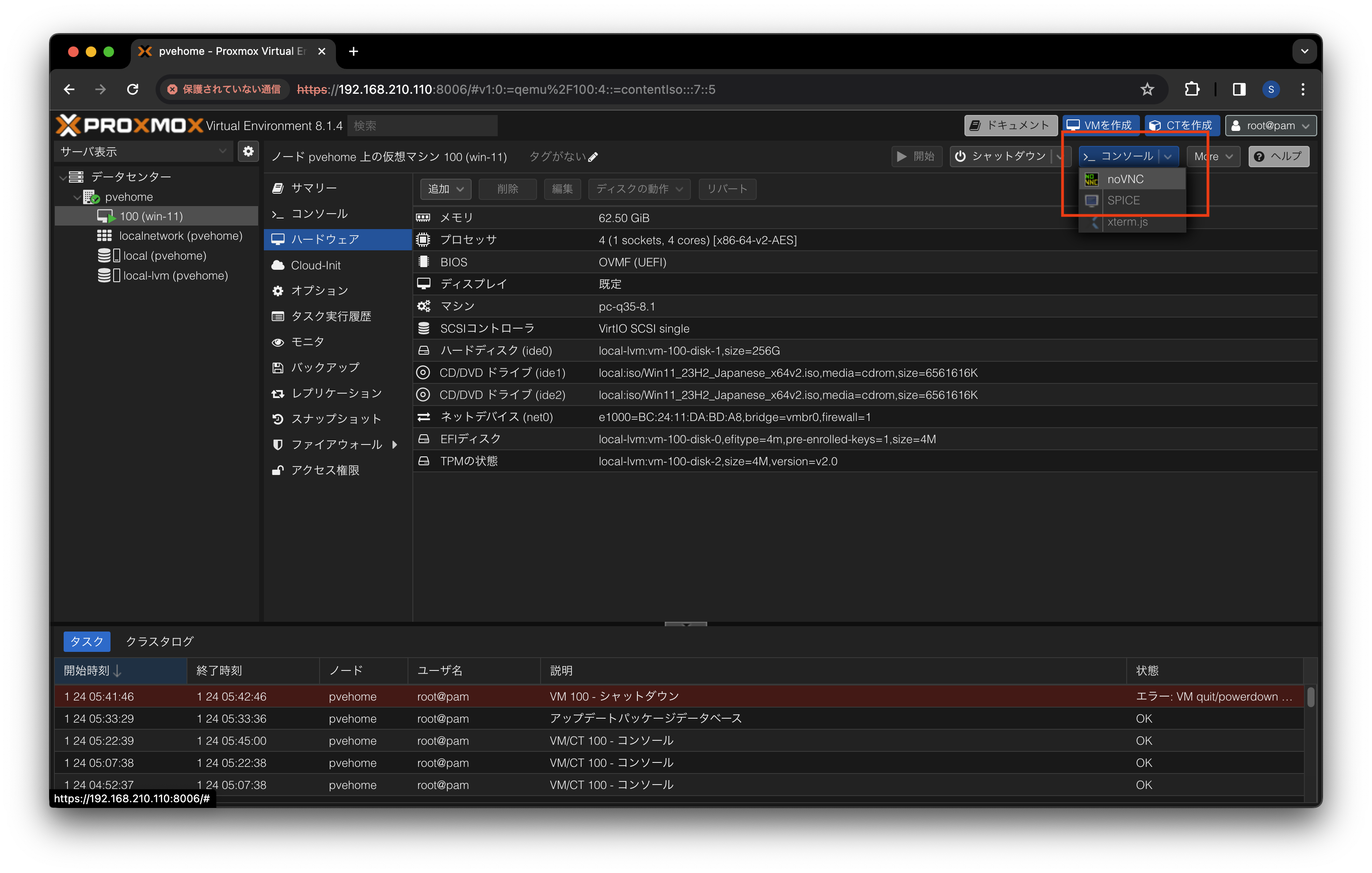

データセンター > 100 (win-11) > コンソール から

noVNCボタンを押下します。

-

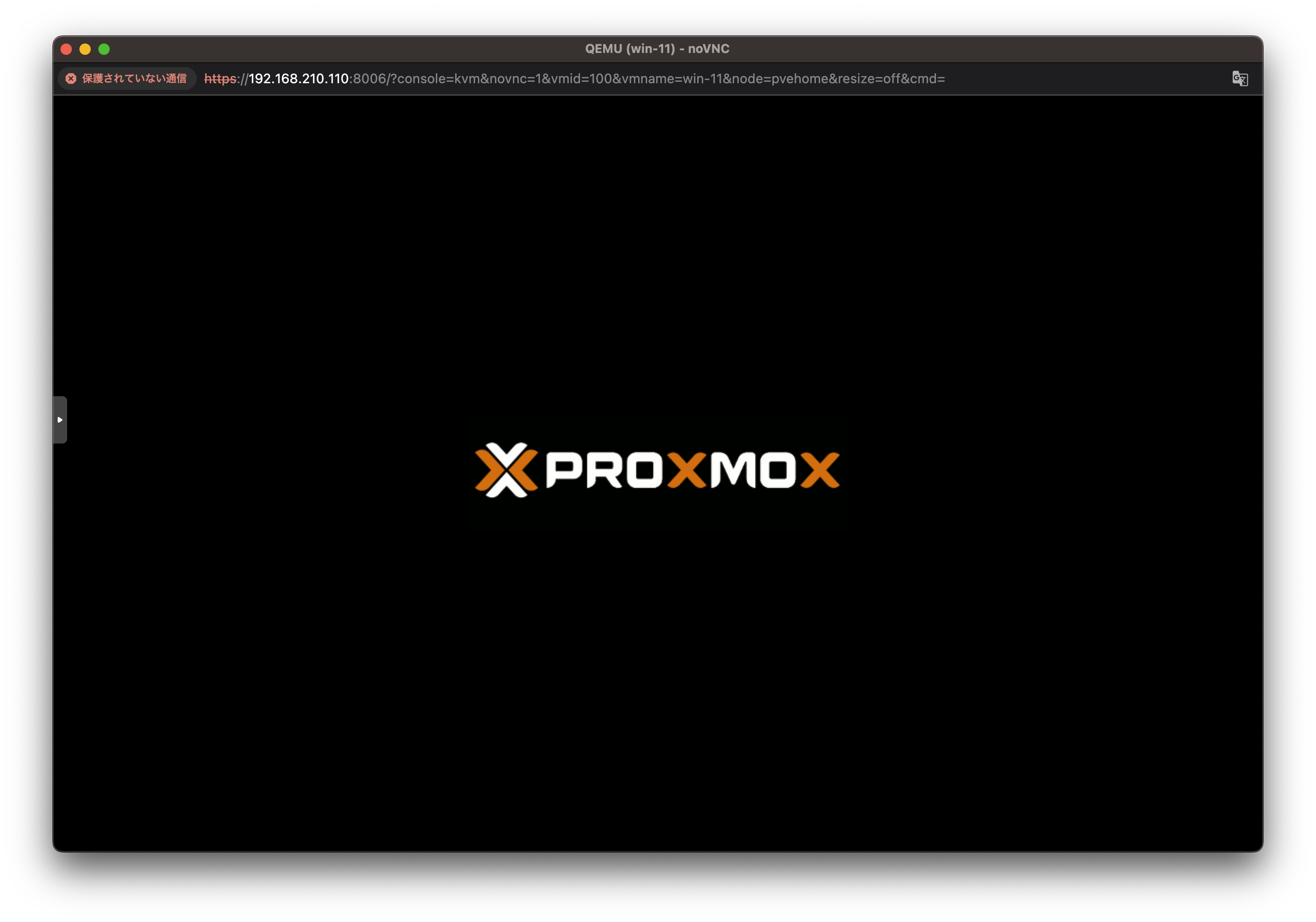

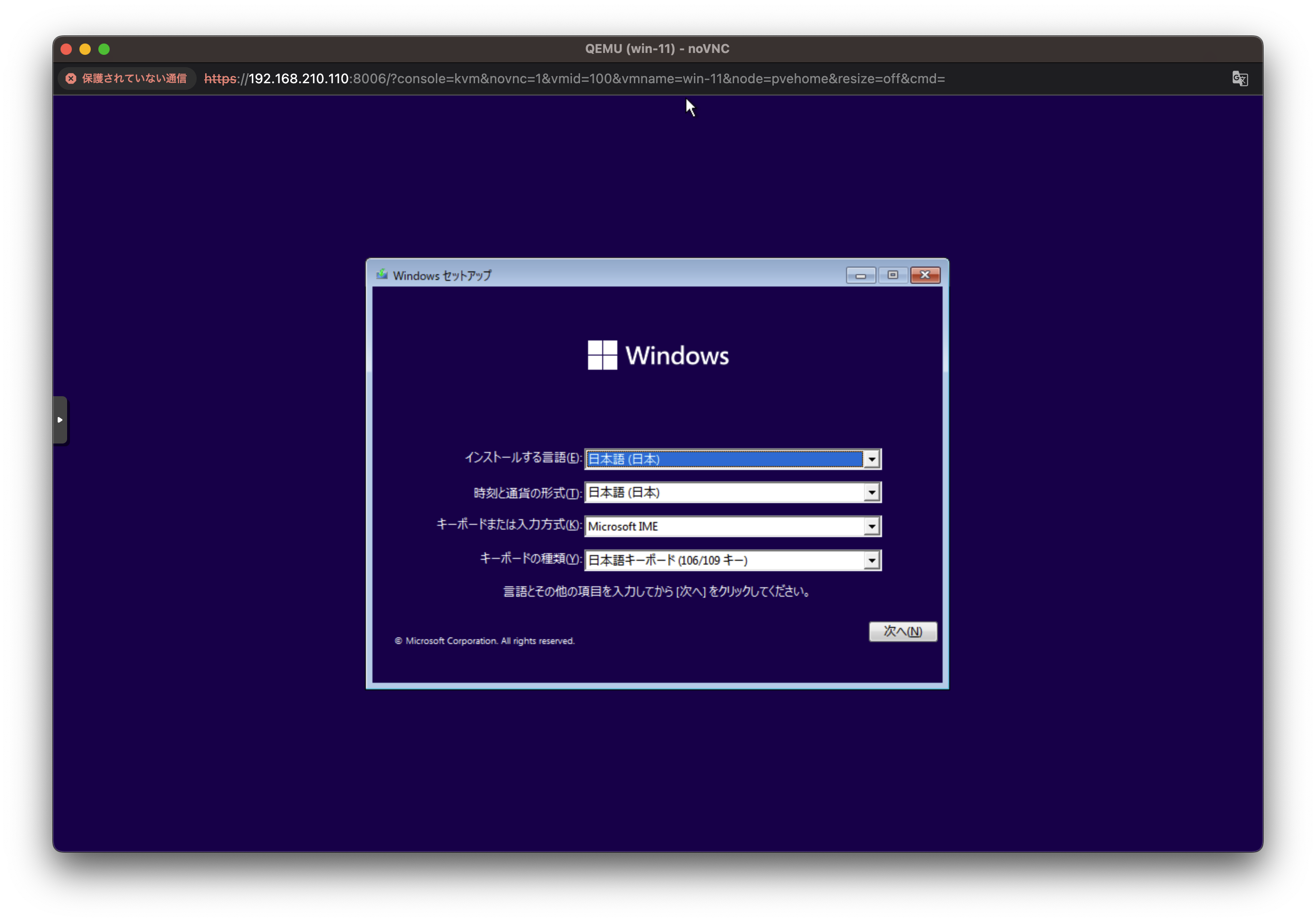

noVNC の画面で Proxmox のロゴが表示されたらなんでもいいのでキーを入力します。

注意: VM を起動してからこの操作まで時間がかかるとネットワークブートになってしまうので、できるだけ早く実施してください。

-

Windwos 11 のセットアップ画面が表示されるので後は通常の手順通りにセットアップを完了します。

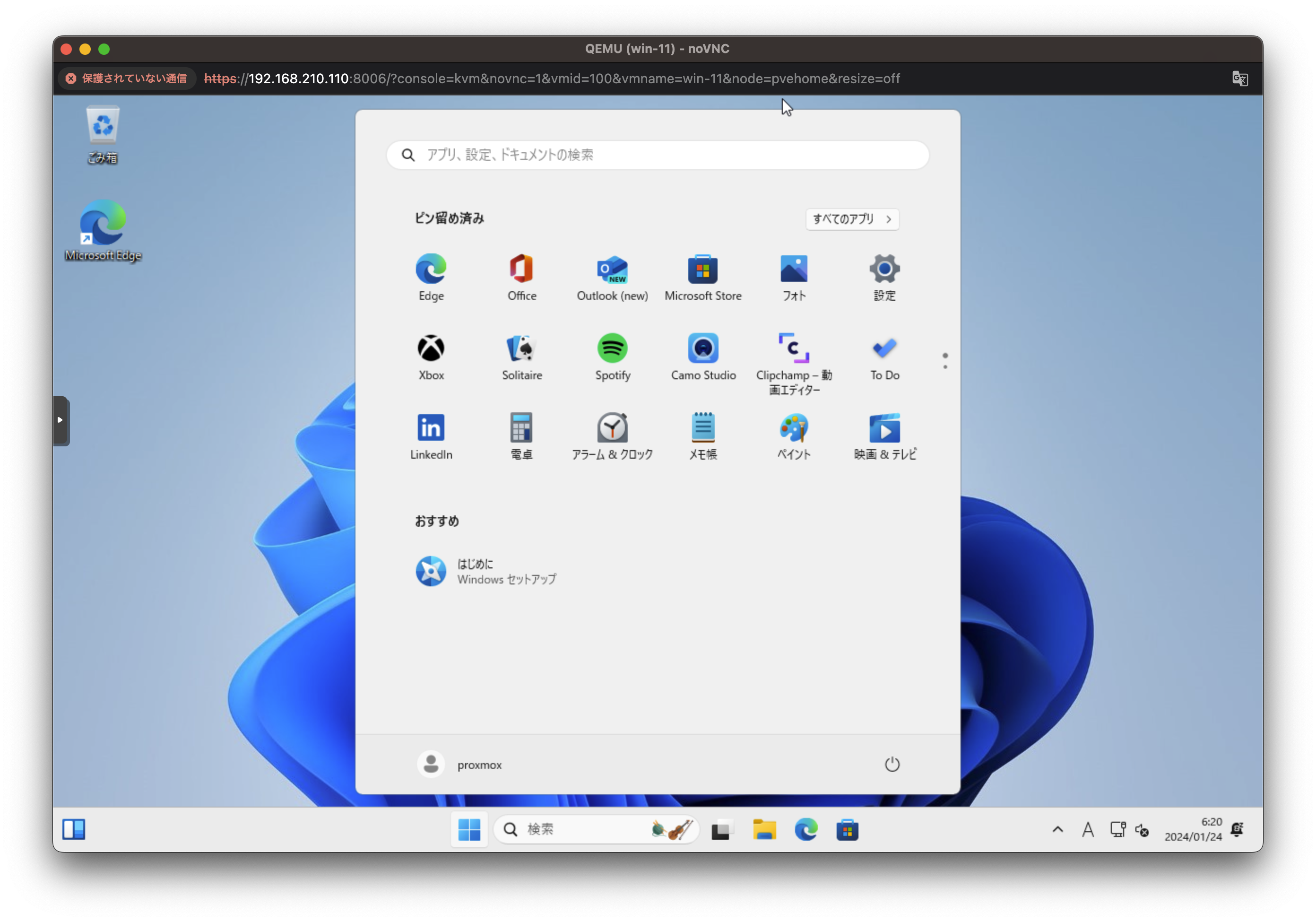

-

セットアップが完了したら Windows 11 が起動します。

CT (コンテナ) の構築

Linux の CT を構築します。

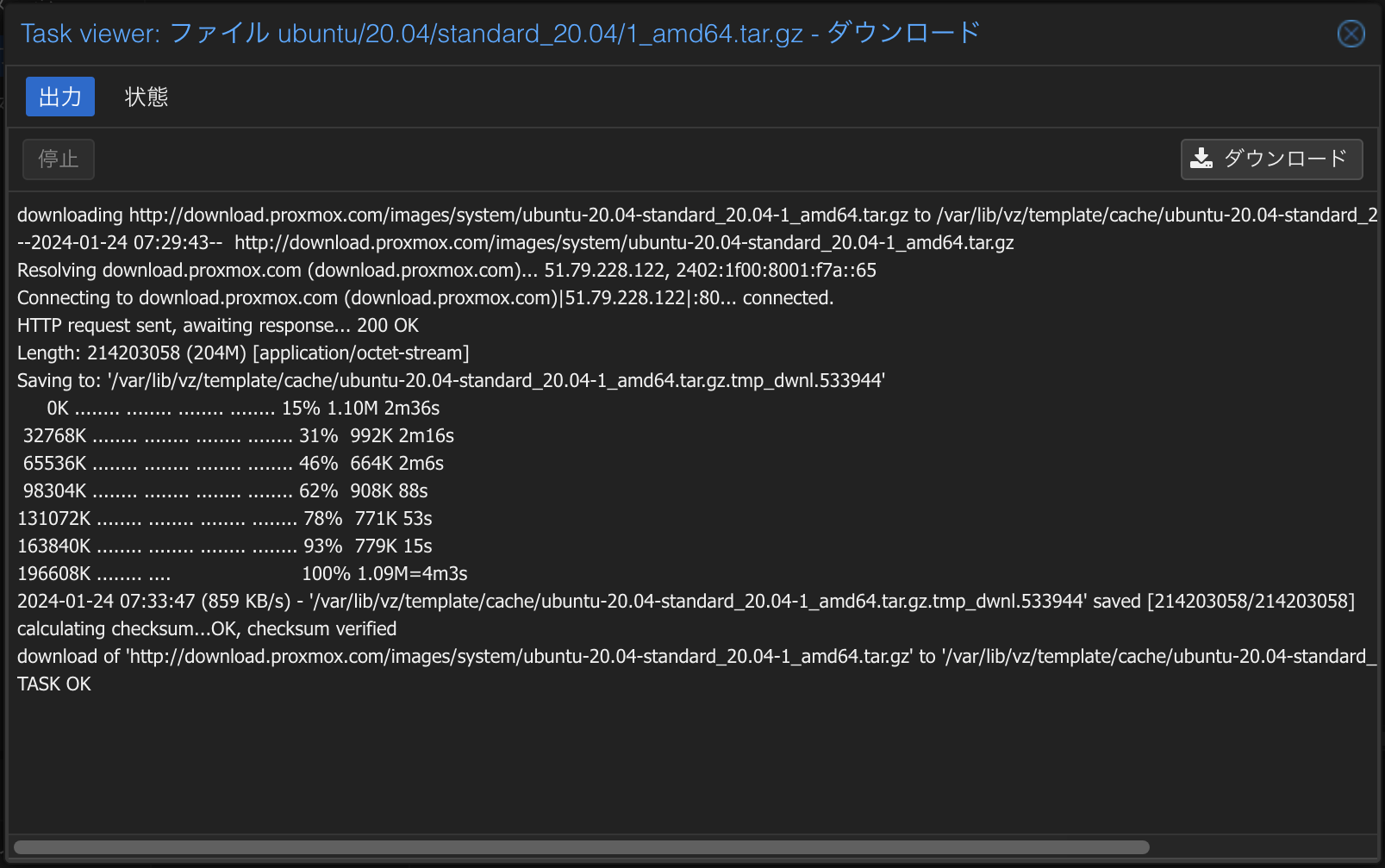

テンプレートのダウンロード

CT のテンプレートをダウンロードします。

-

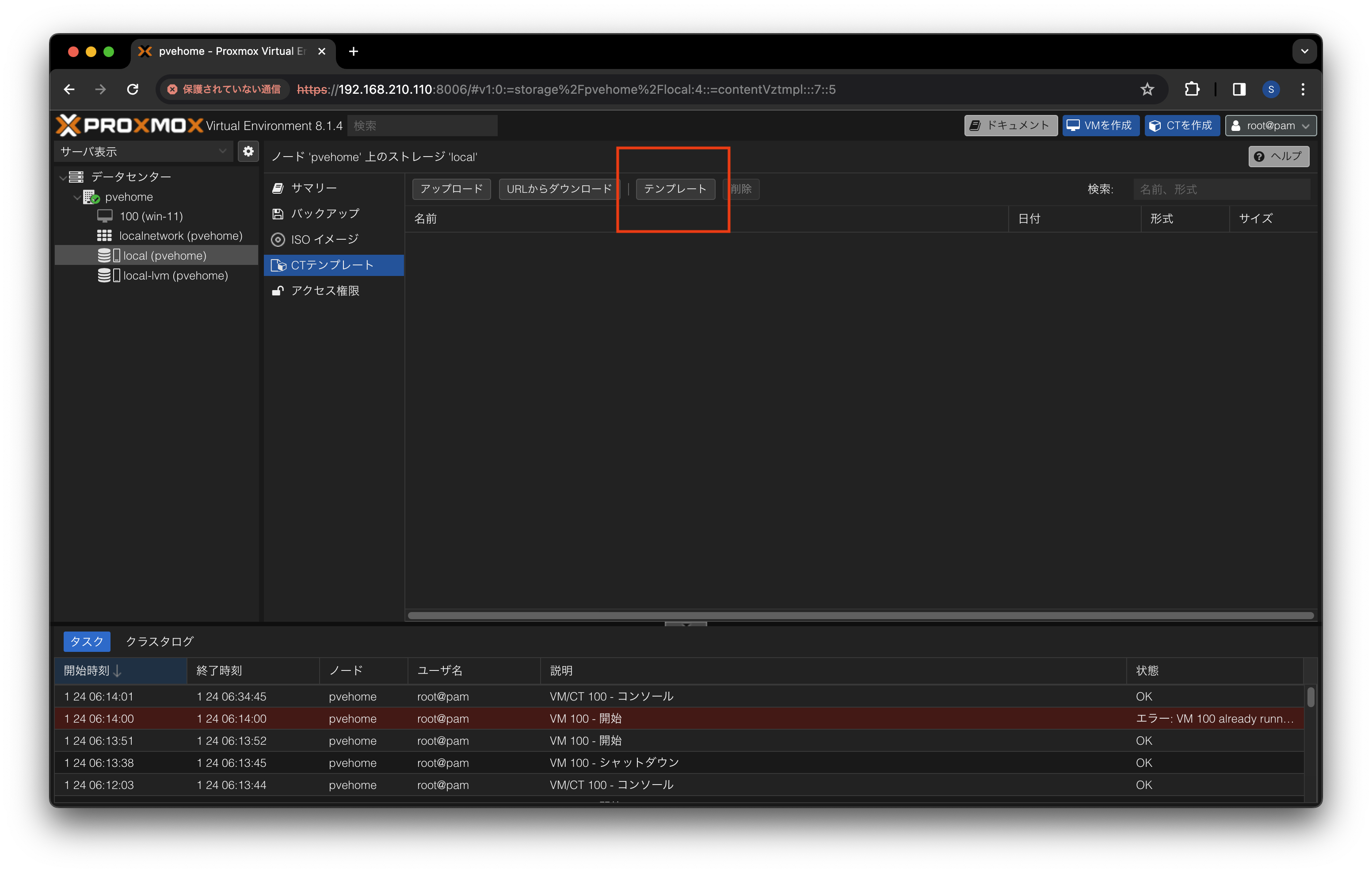

Proxmox VE の管理画面を開きます。

-

データセンター > local > CT テンプレート を開き

テンプレートボタンを押下します。

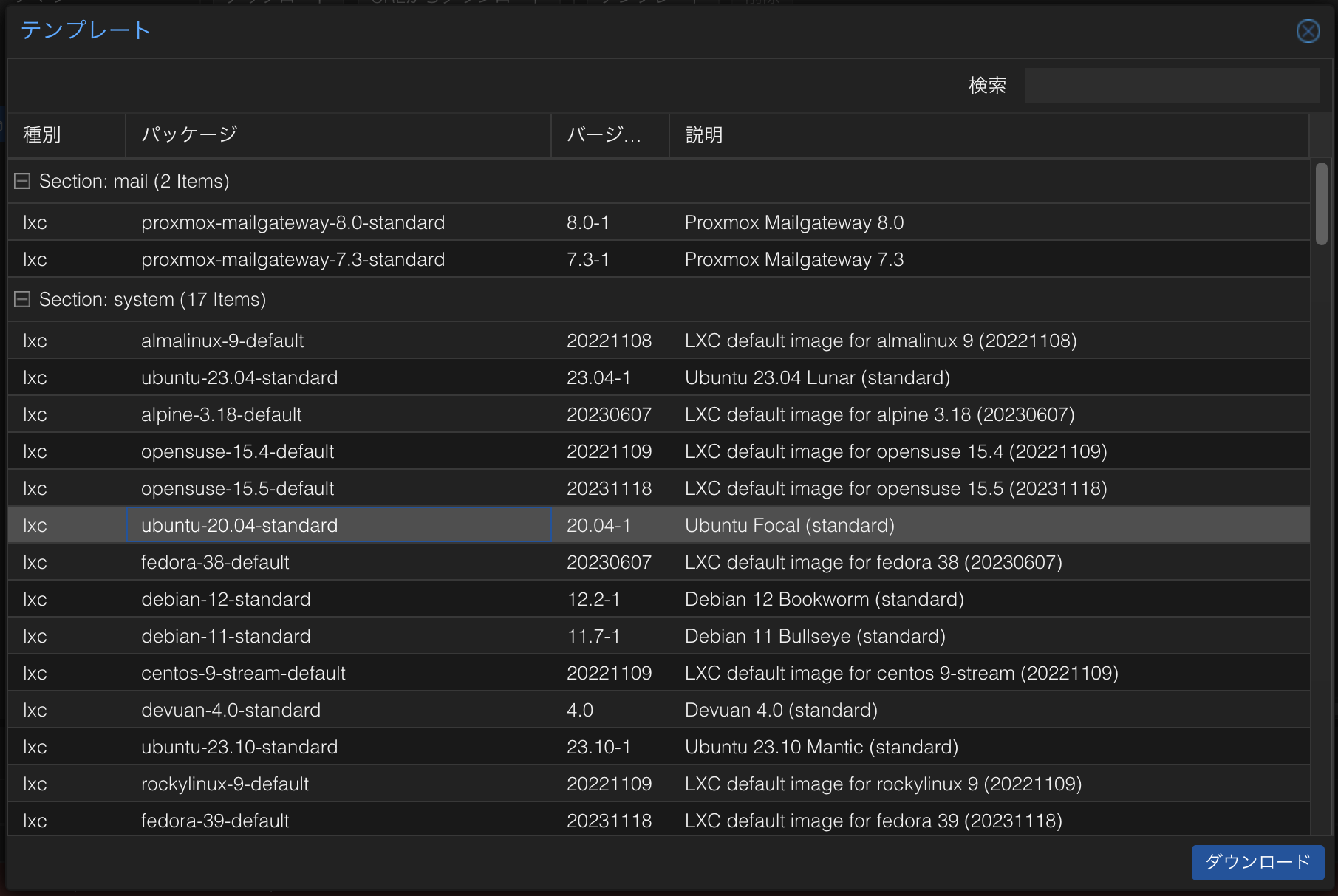

-

テンプレートダイアログで任意のテンプレート w 選択し

ダウンロードボタンを押下します。

-

ダウンロードが完了したら Task viewer を閉じます。

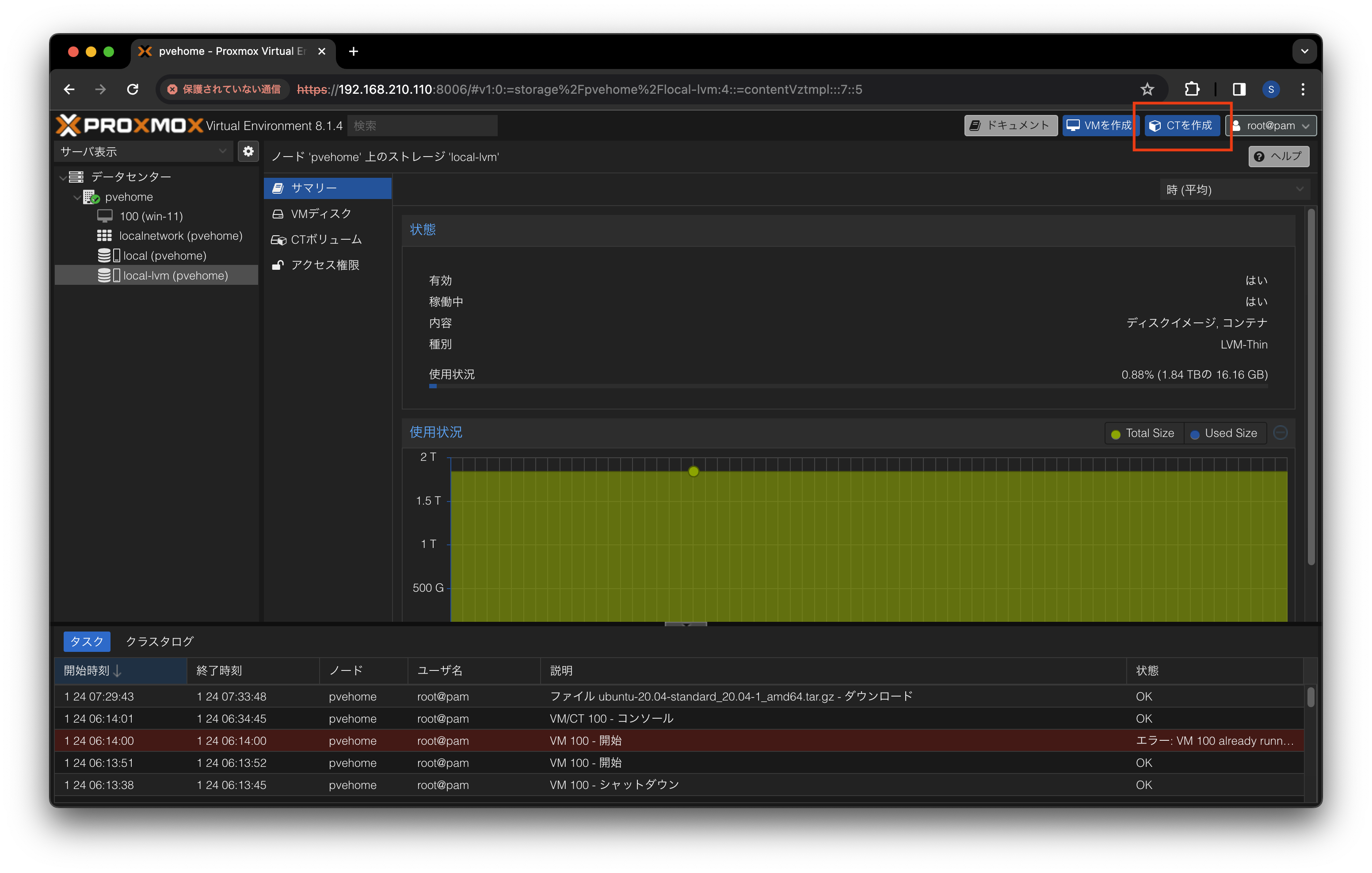

CT を作成

Linux の CT を作成します。

-

Proxmox VE の管理画面を開きます。

-

データセンター > local-lvm を開き

CTを作成ボタンを押下します。

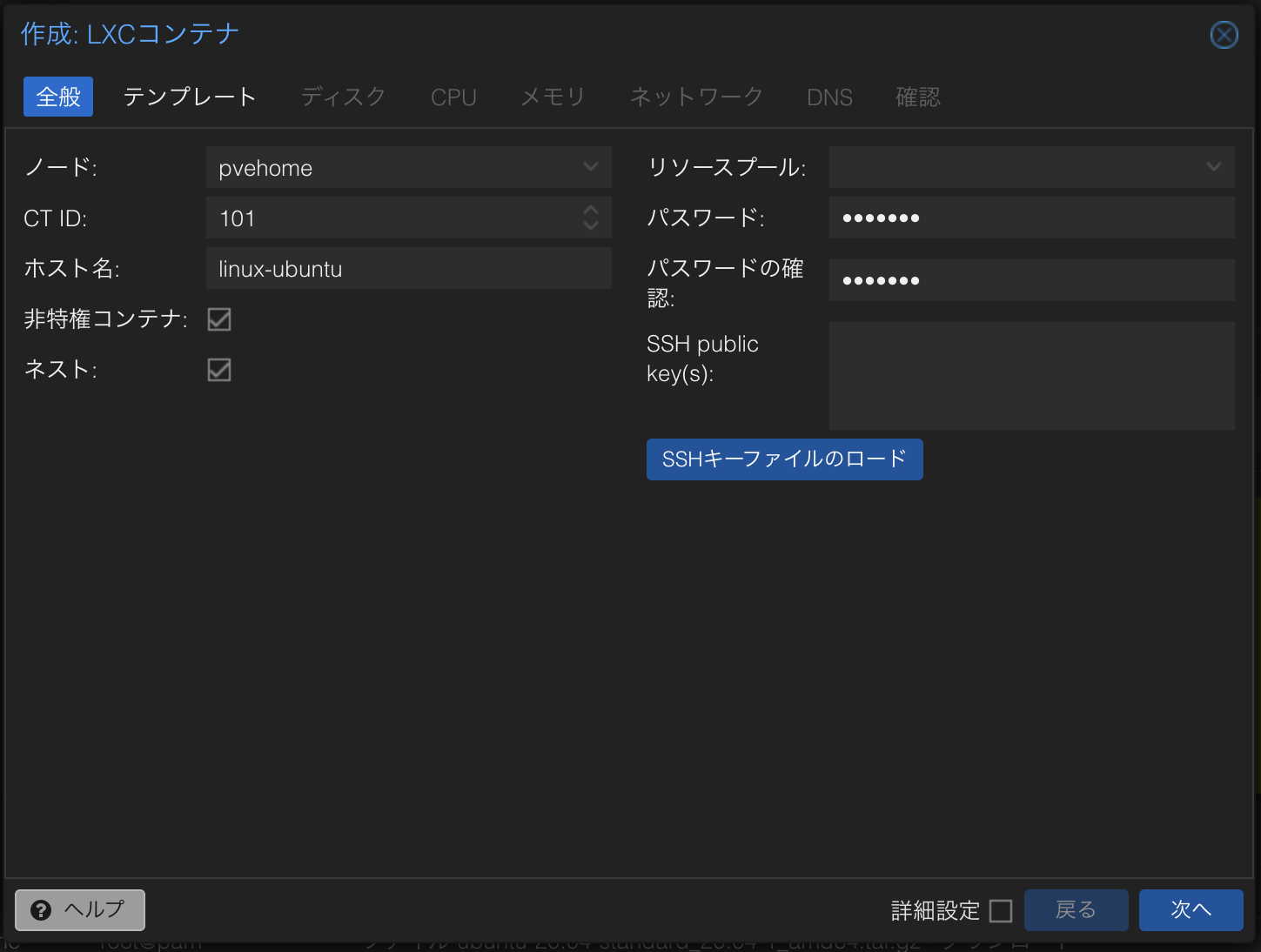

-

全般の情報を入力して

次へボタンを押下します。

- ホスト名: 任意のホスト名を入力します。

- パスワード: 任意のパスワードを入力します。

- パスワードの確認: 任意のパスワードを入力します。

-

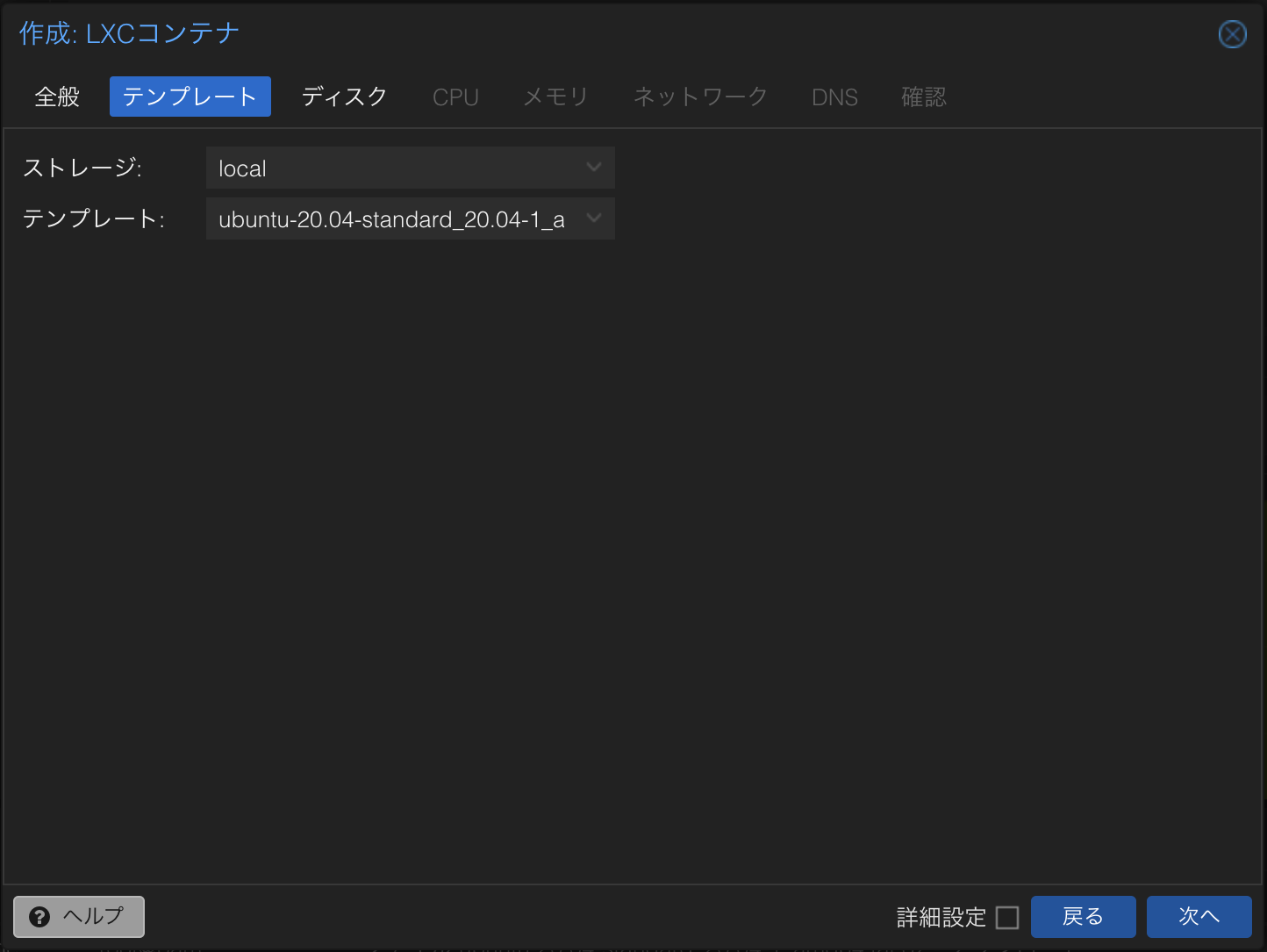

テンプレートの情報を入力して

次へボタンを押下します。

- テンプレート: ダウンロードしたテンプレートを選択します。

-

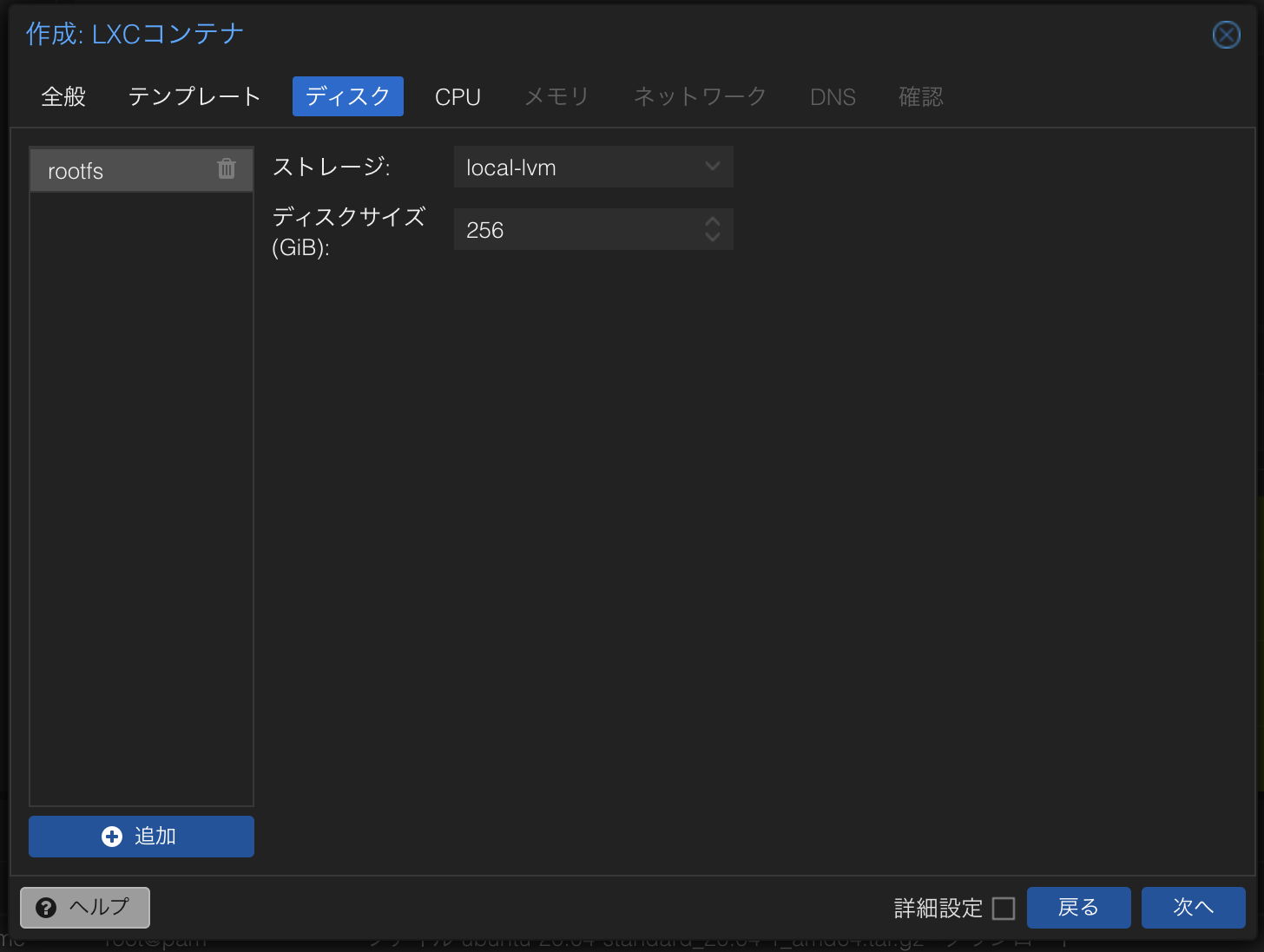

ディスク の情報を入力して

次へボタンを押下します。

- ディスクサイズ (GiB): 任意のサイズを入力します。

-

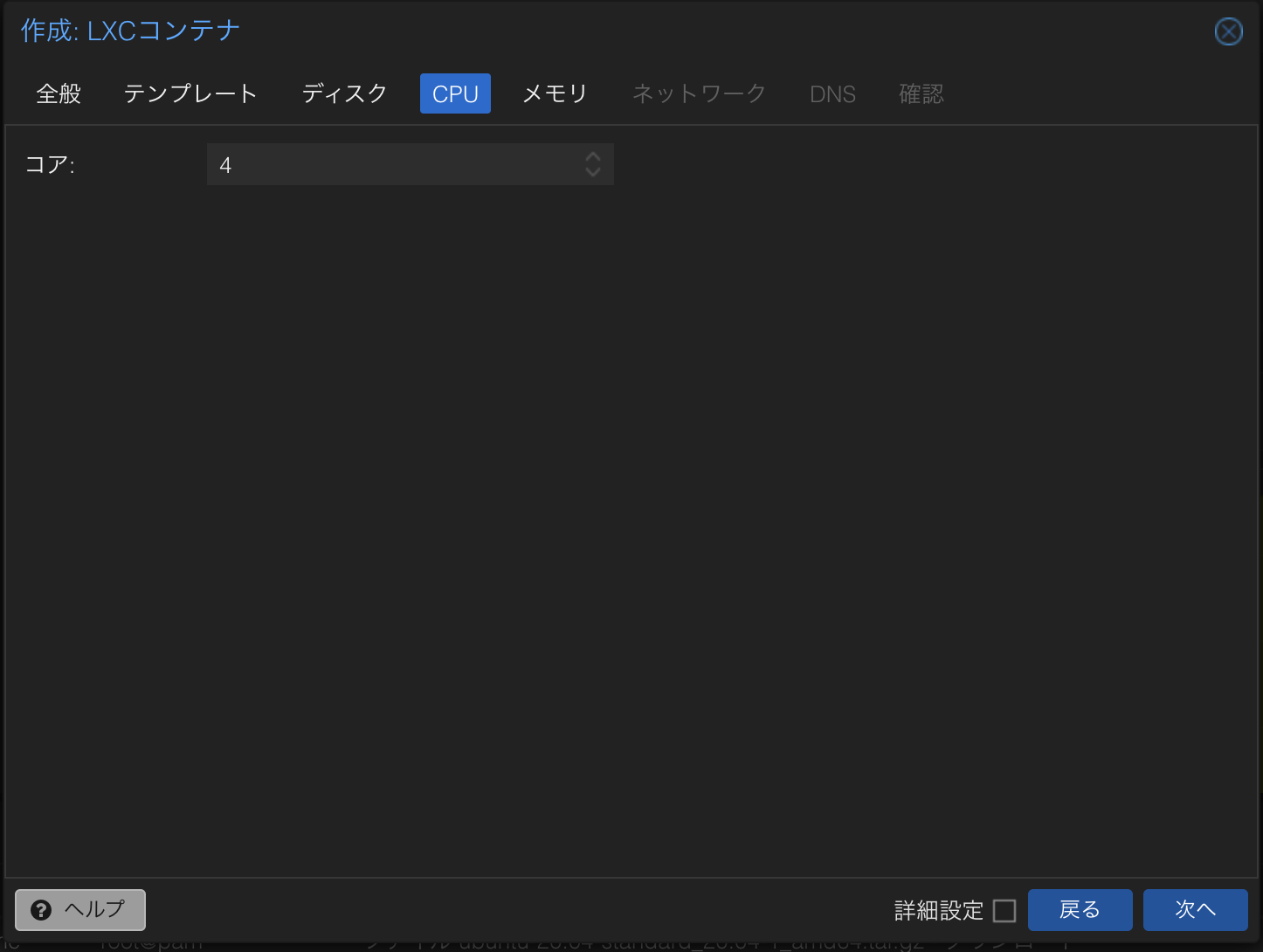

CPU の情報を入力して

次へボタンを押下します。

- コア: 任意のコア数を入力します。

-

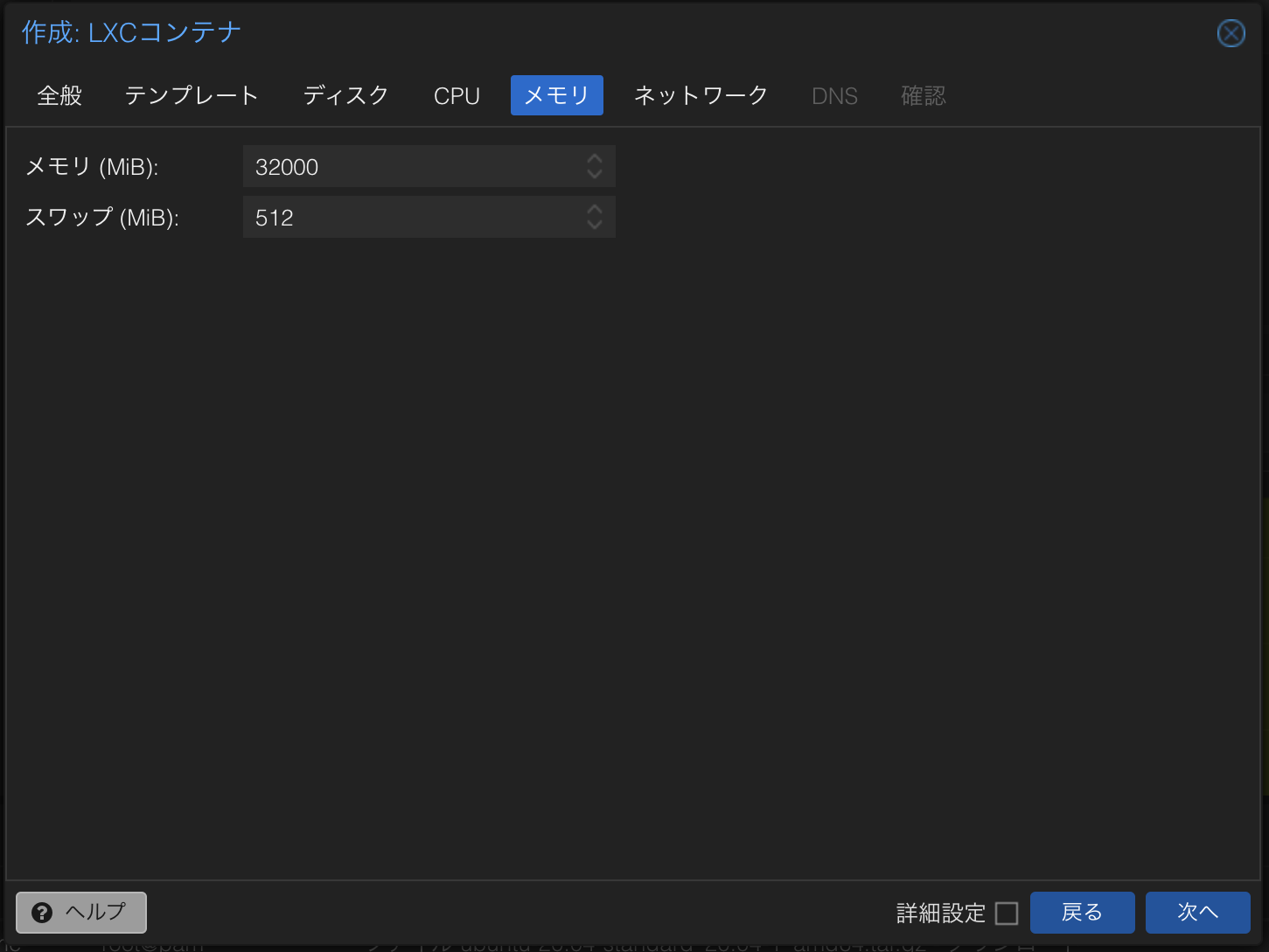

メモリ の情報を入力して

次へボタンを押下します。

- メモリ (MiB): 任意のメモリ容量を入力します。

- スワップ (MiB): 任意のスワップ容量を入力します。

-

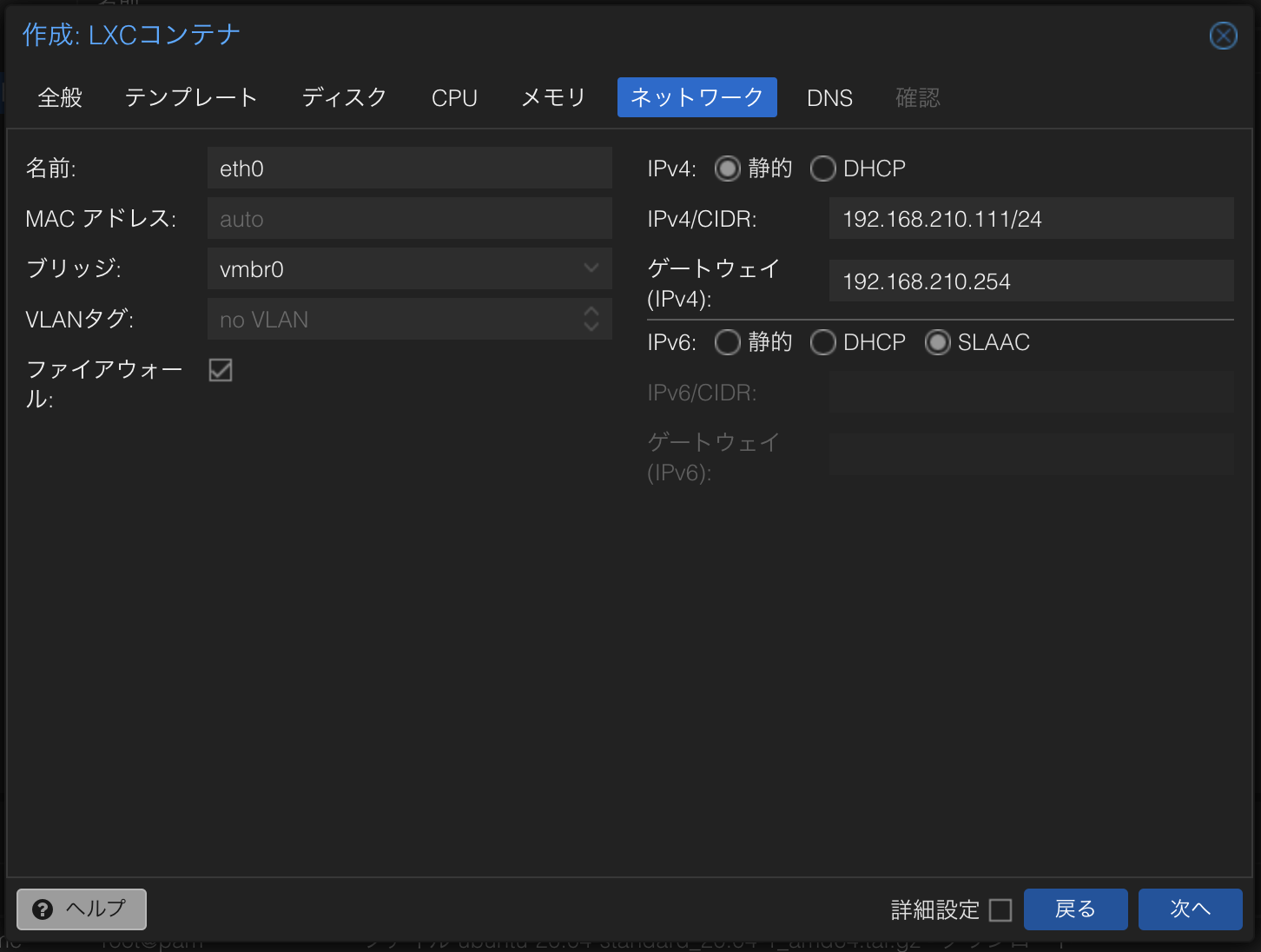

ネットワークの情報を入力して

次へボタンを押下します。

- IPv4: IP アドレスを固定したいので

静的を選択します。 - IPv4/CIDR: 任意のアドレスを入力します。

- ゲートウェイ (IPv4): ルーターのアドレスを入力します。

- IPv6: 自動で設定したいので

SLAACを選択します。

- IPv4: IP アドレスを固定したいので

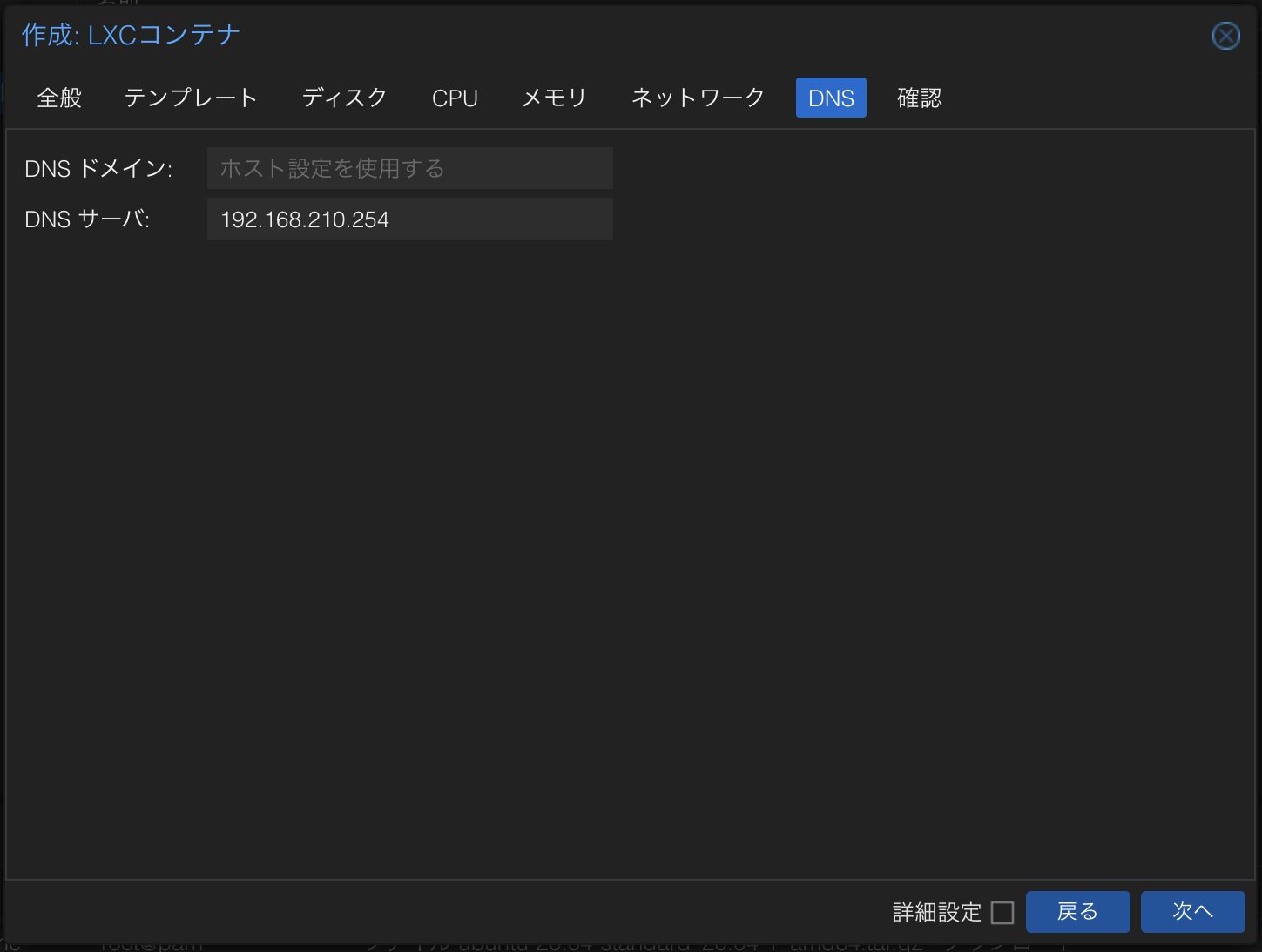

-

DNS の情報を入力して

次へボタンを押下します。

- DNS サーバ: ルーターのアドレスを入力します。

-

確認 で問題なければ

完了ボタンを押下します。

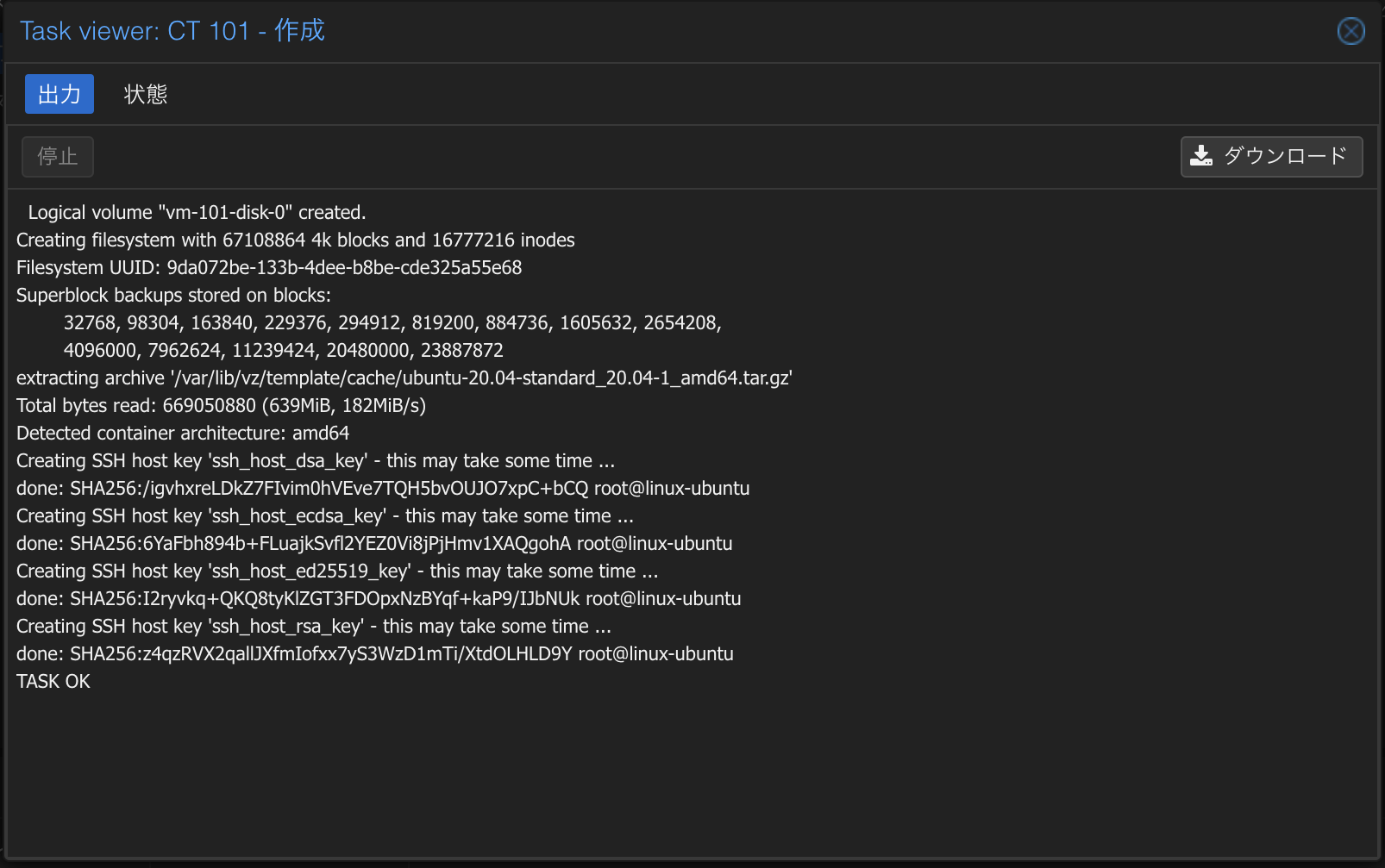

-

CT の作成が完了したら Task viewer を閉じます。

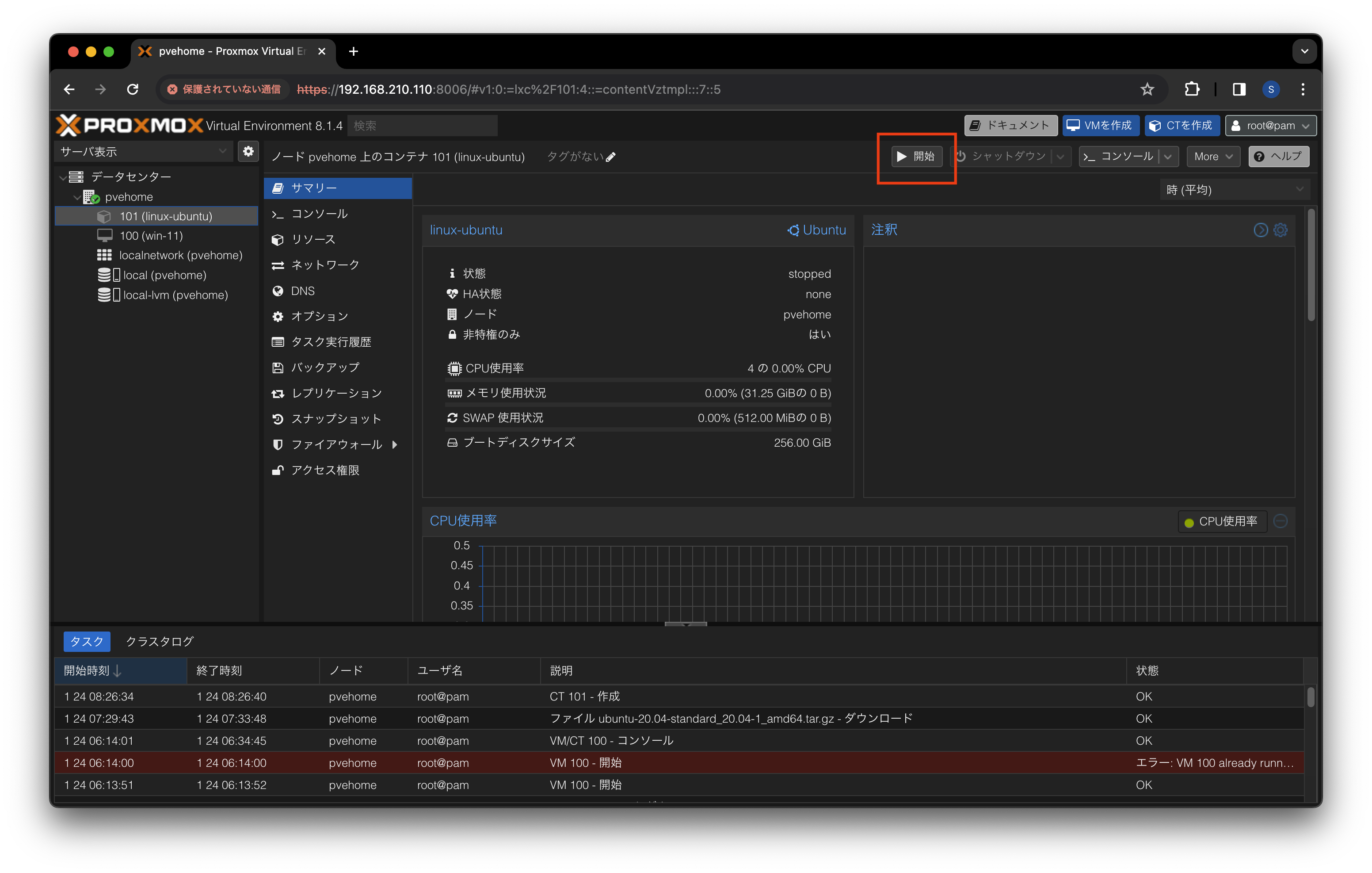

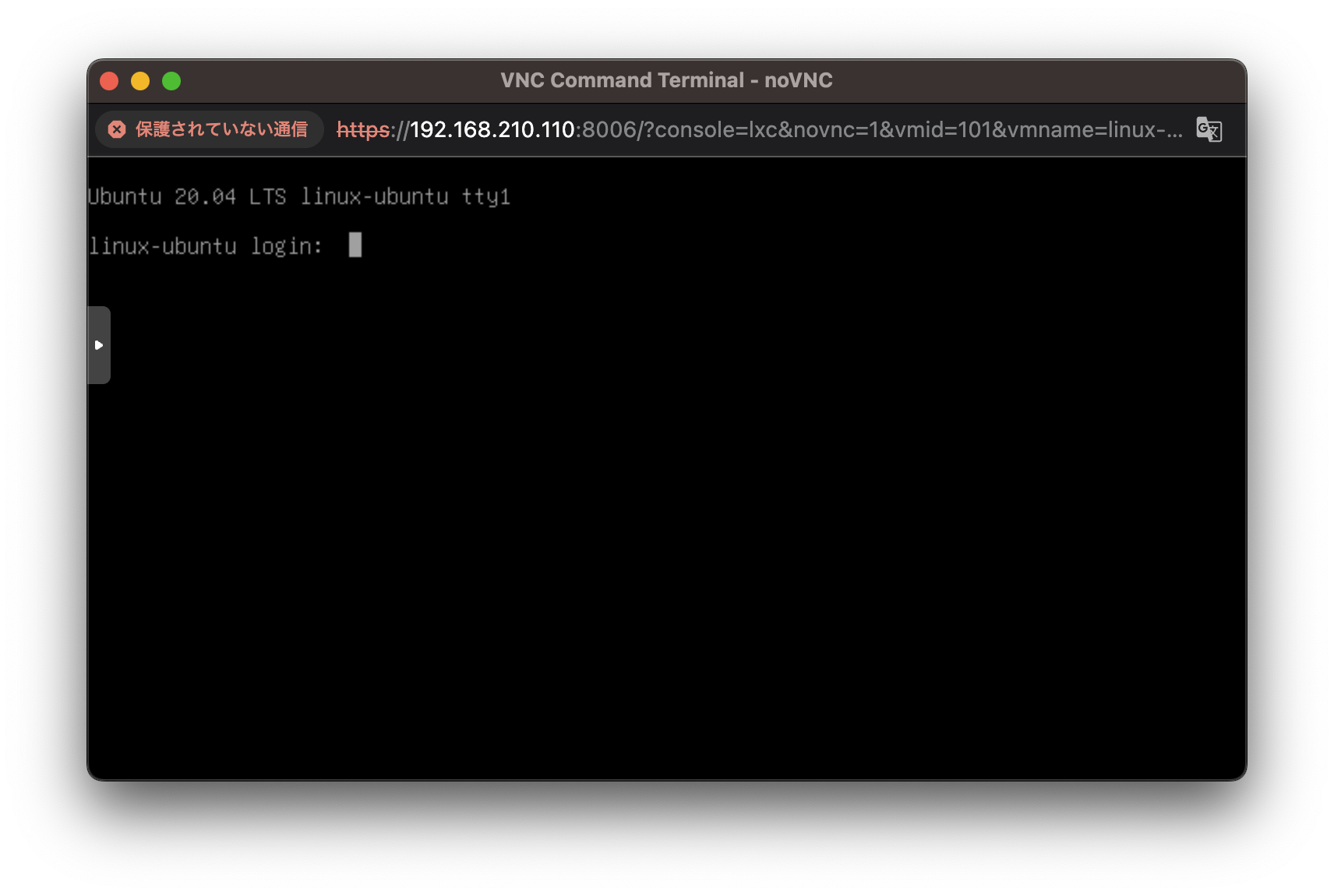

CT の起動

Linux の CT を起動します。

-

Proxmox VE の管理画面を開きます。

-

データセンター > 101 (linux-ubuntu) > から

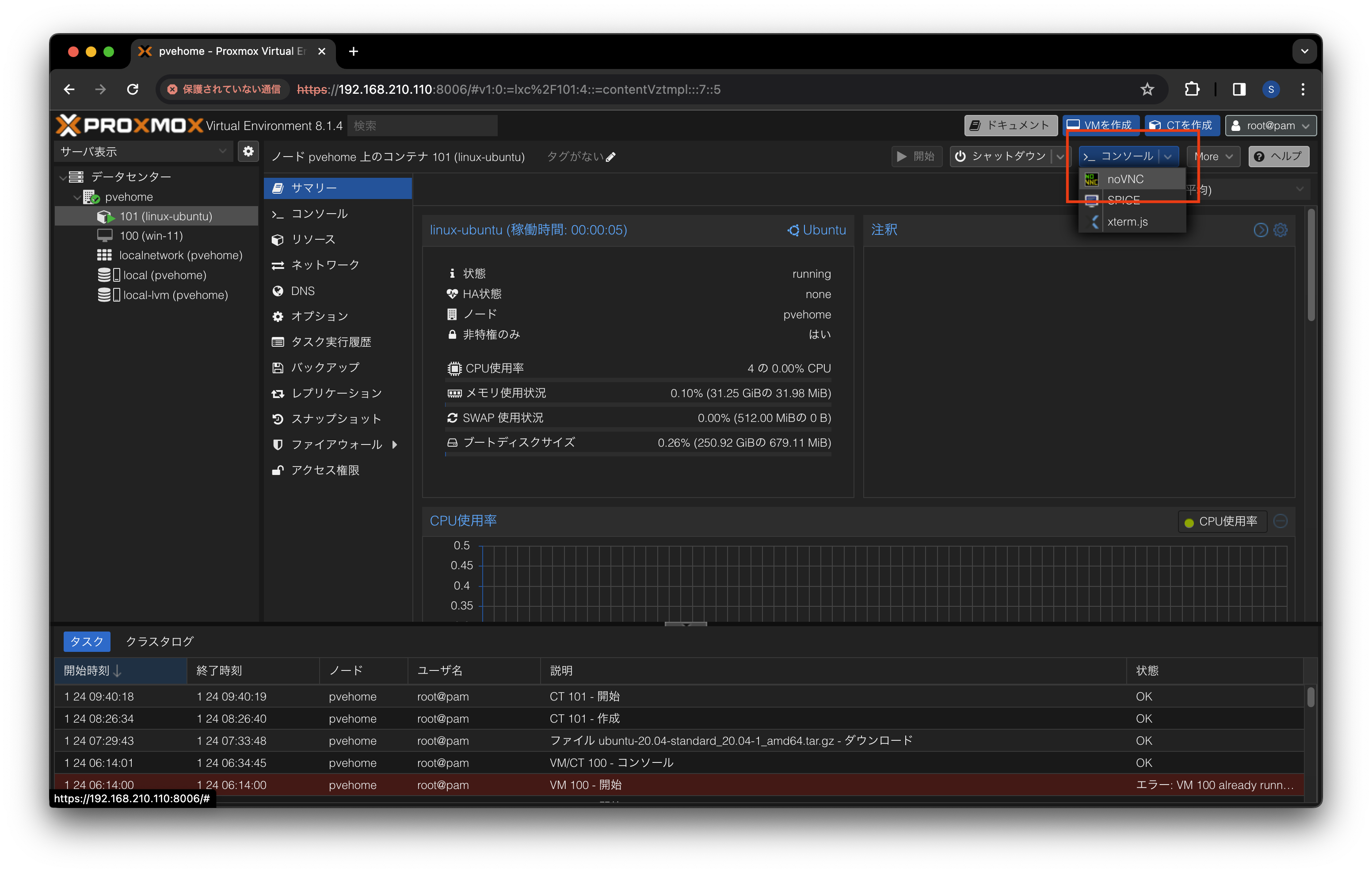

開始ボタンを押下します。

-

データセンター > 101 (linux-ubuntu) > コンソール から

noVNCボタンを押下します。

-

noVNC の画面で Linux の CT にログインすることができます。

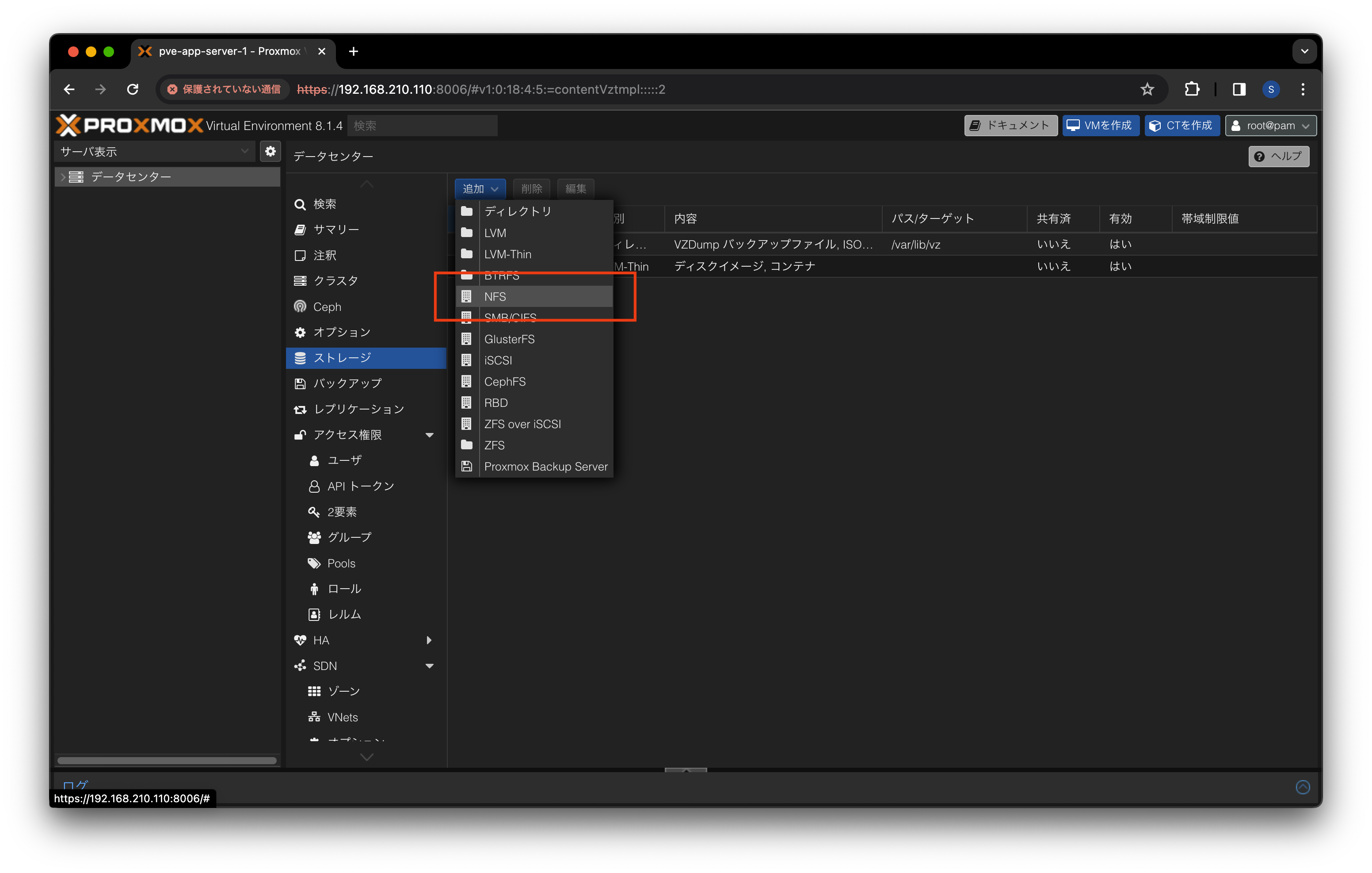

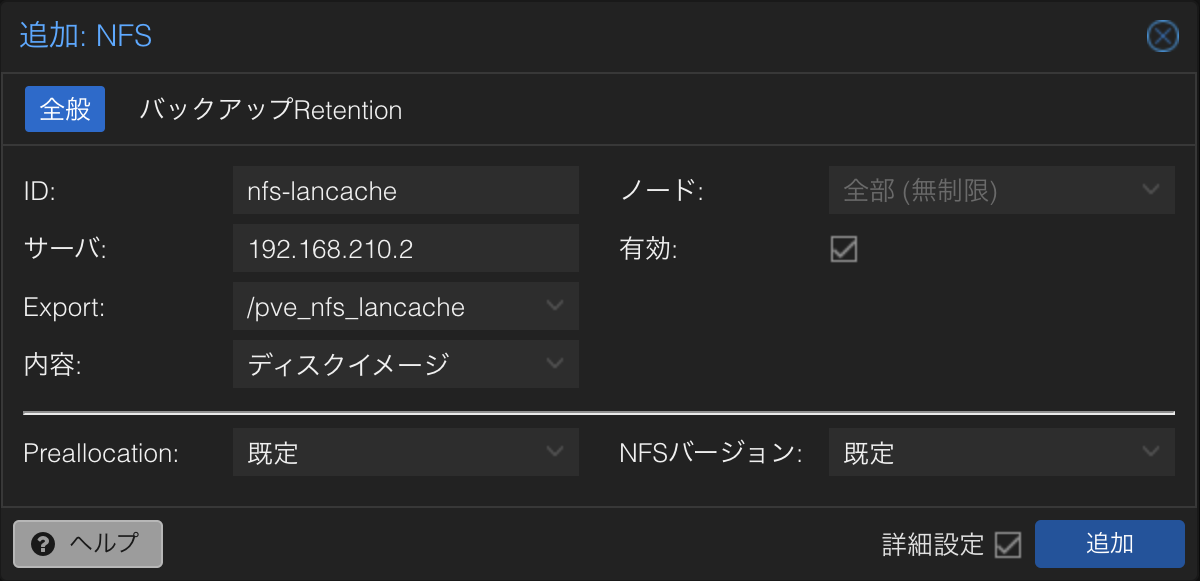

NFS ストレージの追加

こちら で作成した NFS 共有フォルダを追加します。

-

Proxmox VE の管理画面を開きます。

-

データセンター > ストレージ > 作成 を開き

NFSを押下します。

-

追加する NFS の情報を入力し

追加ボタンを押下します。

- ID: 任意の値を入力します。

- サーバ: NFS 共有フォルダのアドレスを入力します。

- Export: 任意の値を選択します。

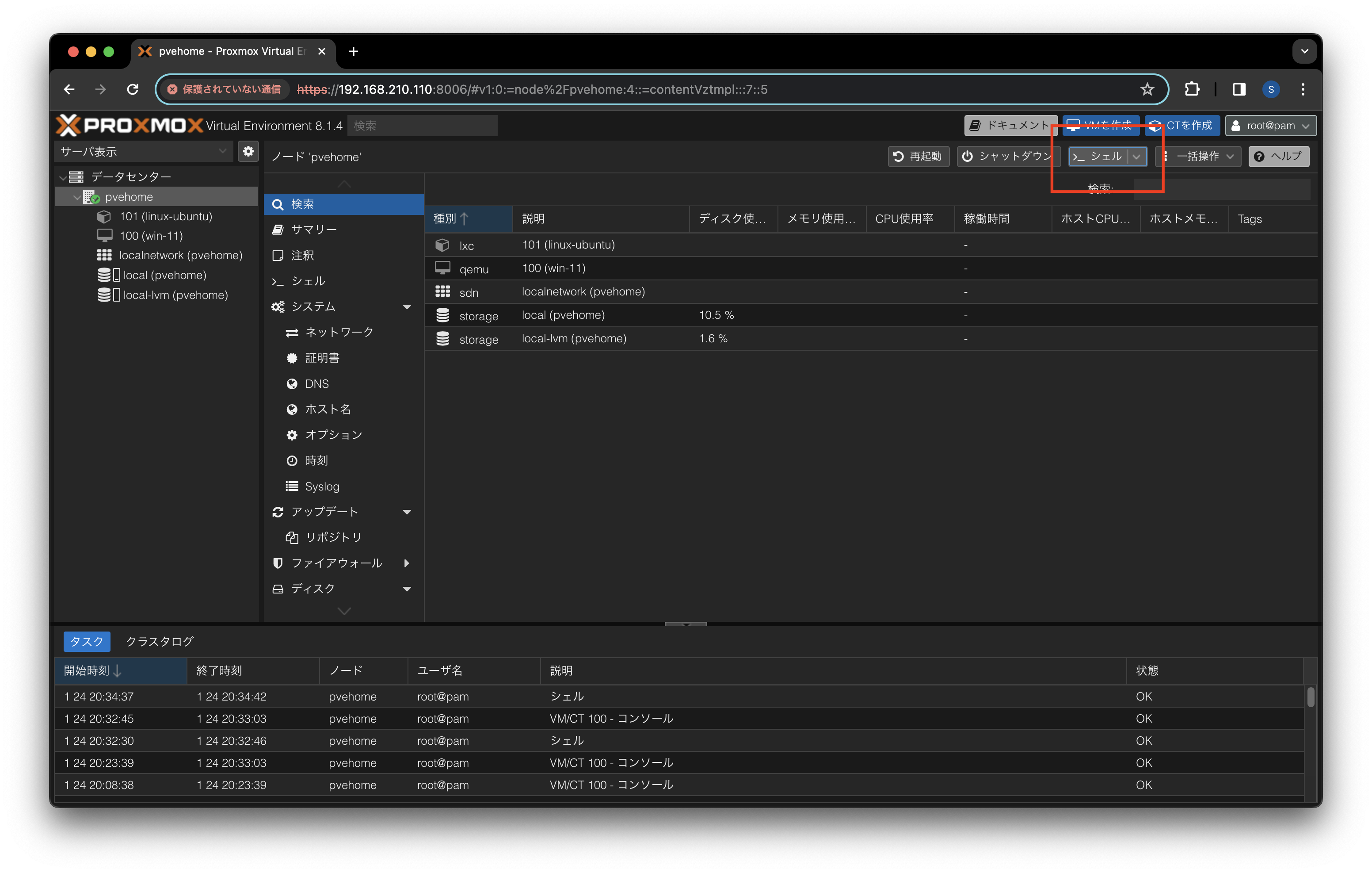

GPU パススルー

PCI Passthrough を参考に GPU パススルーの設定を行います。

-

Proxmox VE の管理画面を開きます。

-

データセンターからノード

pvehomeを選択しシェルボタンを押下します。

-

別ウィンドウでシェルが開きます。以降のコマンド入力はシェルで行います。

-

エディタで設定ファイル

/etc/default/grubを開きます。vi /etc/default/grub -

GRUB_CMDLINE_LINUX_DEFAULT に

amd_iommu=onを追記しエディタを閉じます。# GRUB_CMDLINE_LINUX_DEFAULT="quiet" GRUB_CMDLINE_LINUX_DEFAULT="quiet amd_iommu=on" -

次のコマンドで IOMMU が有効になっていることを確認します。

dmesg | grep -e DMAR -e IOMMU実行ログ

root@pvehome:~# dmesg | grep -e DMAR -e IOMMU [ 0.581615] pci 0000:00:00.2: AMD-Vi: IOMMU performance counters supported [ 0.582941] pci 0000:00:00.2: AMD-Vi: Found IOMMU cap 0x40 [ 0.676068] perf/amd_iommu: Detected AMD IOMMU #0 (2 banks, 4 counters/bank). -

次のコマンドで IOMMU 割り込みの再マッピングが有効になっていることを確認します。

dmesg | grep 'remapping'実行ログ

root@pvehome:~# dmesg | grep 'remapping' [ 0.582950] AMD-Vi: Interrupt remapping enabled -

次のコマンドで IOMMU 分離を確認します。

pvehomeのノード名は適時変更してください。pvesh get /nodes/pvehome/hardware/pci --pci-class-blacklist ""実行ログ

root@pvehome:~# pvesh get /nodes/pvehome/hardware/pci --pci-class-blacklist "" ┌──────────┬────────┬──────────────┬────────────┬────────┬──────────────────────────── │ class │ device │ id │ iommugroup │ vendor │ device_name ╞══════════╪════════╪══════════════╪════════════╪════════╪════════════════════════════ │ 0x010601 │ 0x7901 │ 0000:05:00.0 │ 2 │ 0x1022 │ FCH SATA Controller [AHCI m ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x010802 │ 0xa808 │ 0000:02:00.0 │ 1 │ 0x144d │ NVMe SSD Controller SM981/P ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x020000 │ 0x8168 │ 0000:03:00.0 │ 1 │ 0x10ec │ RTL8111/8168/8411 PCI Expre ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x030000 │ 0x27b0 │ 0000:01:00.0 │ 0 │ 0x10de │ AD104GL [RTX 4000 SFF Ada G ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x040300 │ 0x22bc │ 0000:01:00.1 │ 0 │ 0x10de │ ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x040300 │ 0x1637 │ 0000:04:00.1 │ 2 │ 0x1002 │ Renoir Radeon High Definiti ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x040300 │ 0x15e3 │ 0000:04:00.6 │ 2 │ 0x1022 │ Family 17h/19h HD Audio Con ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1630 │ 0000:00:00.0 │ -1 │ 0x1022 │ Renoir/Cezanne Root Complex ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1632 │ 0000:00:01.0 │ 0 │ 0x1022 │ Renoir PCIe Dummy Host Brid ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1632 │ 0000:00:02.0 │ 1 │ 0x1022 │ Renoir PCIe Dummy Host Brid ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1632 │ 0000:00:08.0 │ 2 │ 0x1022 │ Renoir PCIe Dummy Host Brid ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166a │ 0000:00:18.0 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166b │ 0000:00:18.1 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166c │ 0000:00:18.2 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166d │ 0000:00:18.3 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166e │ 0000:00:18.4 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x166f │ 0000:00:18.5 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1670 │ 0000:00:18.6 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060000 │ 0x1671 │ 0000:00:18.7 │ 4 │ 0x1022 │ Cezanne Data Fabric; Functi ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060100 │ 0x790e │ 0000:00:14.3 │ 3 │ 0x1022 │ FCH LPC Bridge ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060400 │ 0x1633 │ 0000:00:01.1 │ 0 │ 0x1022 │ Renoir PCIe GPP Bridge ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060400 │ 0x1634 │ 0000:00:02.1 │ 1 │ 0x1022 │ Renoir/Cezanne PCIe GPP Bri ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060400 │ 0x1634 │ 0000:00:02.3 │ 1 │ 0x1022 │ Renoir/Cezanne PCIe GPP Bri ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060400 │ 0x1635 │ 0000:00:08.1 │ 2 │ 0x1022 │ Renoir Internal PCIe GPP Br ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x060400 │ 0x1635 │ 0000:00:08.2 │ 2 │ 0x1022 │ Renoir Internal PCIe GPP Br ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x080600 │ 0x1631 │ 0000:00:00.2 │ -1 │ 0x1022 │ Renoir/Cezanne IOMMU ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x0c0330 │ 0x1639 │ 0000:04:00.3 │ 2 │ 0x1022 │ Renoir/Cezanne USB 3.1 ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x0c0330 │ 0x1639 │ 0000:04:00.4 │ 2 │ 0x1022 │ Renoir/Cezanne USB 3.1 ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x0c0500 │ 0x790b │ 0000:00:14.0 │ 3 │ 0x1022 │ FCH SMBus Controller ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x108000 │ 0x15df │ 0000:04:00.2 │ 2 │ 0x1022 │ Family 17h (Models 10h-1fh) ├──────────┼────────┼──────────────┼────────────┼────────┼──────────────────────────── │ 0x130000 │ 0x145a │ 0000:04:00.0 │ 2 │ 0x1022 │ Zeppelin/Raven/Raven2 PCIe └──────────┴────────┴──────────────┴────────────┴────────┴──────────────────────────── -

次のコマンドでドライバーのブラックリストへの登録を行います。

echo "blacklist nouveau" >> /etc/modprobe.d/blacklist.conf echo "blacklist nvidia*" >> /etc/modprobe.d/blacklist.conf実行ログ

root@pvehome:~# echo "blacklist nouveau" >> /etc/modprobe.d/blacklist.conf root@pvehome:~# echo "blacklist nvidia*" >> /etc/modprobe.d/blacklist.conf -

Proxmox VE を再起動します。

-

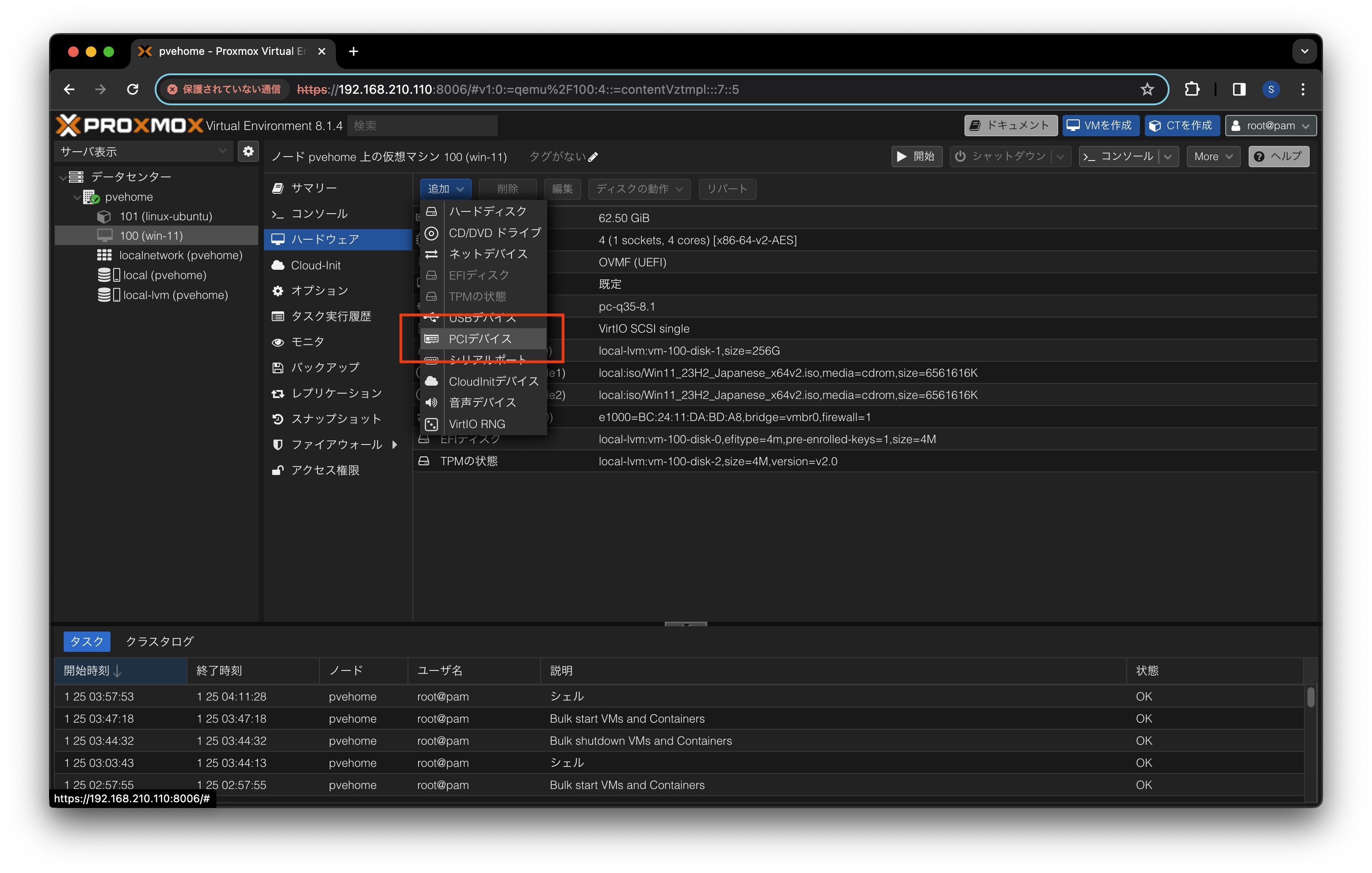

データセンター > 100 (win-11) > ハードウェア から

追加ボタンを押下しPCI デバイスを選択します。

-

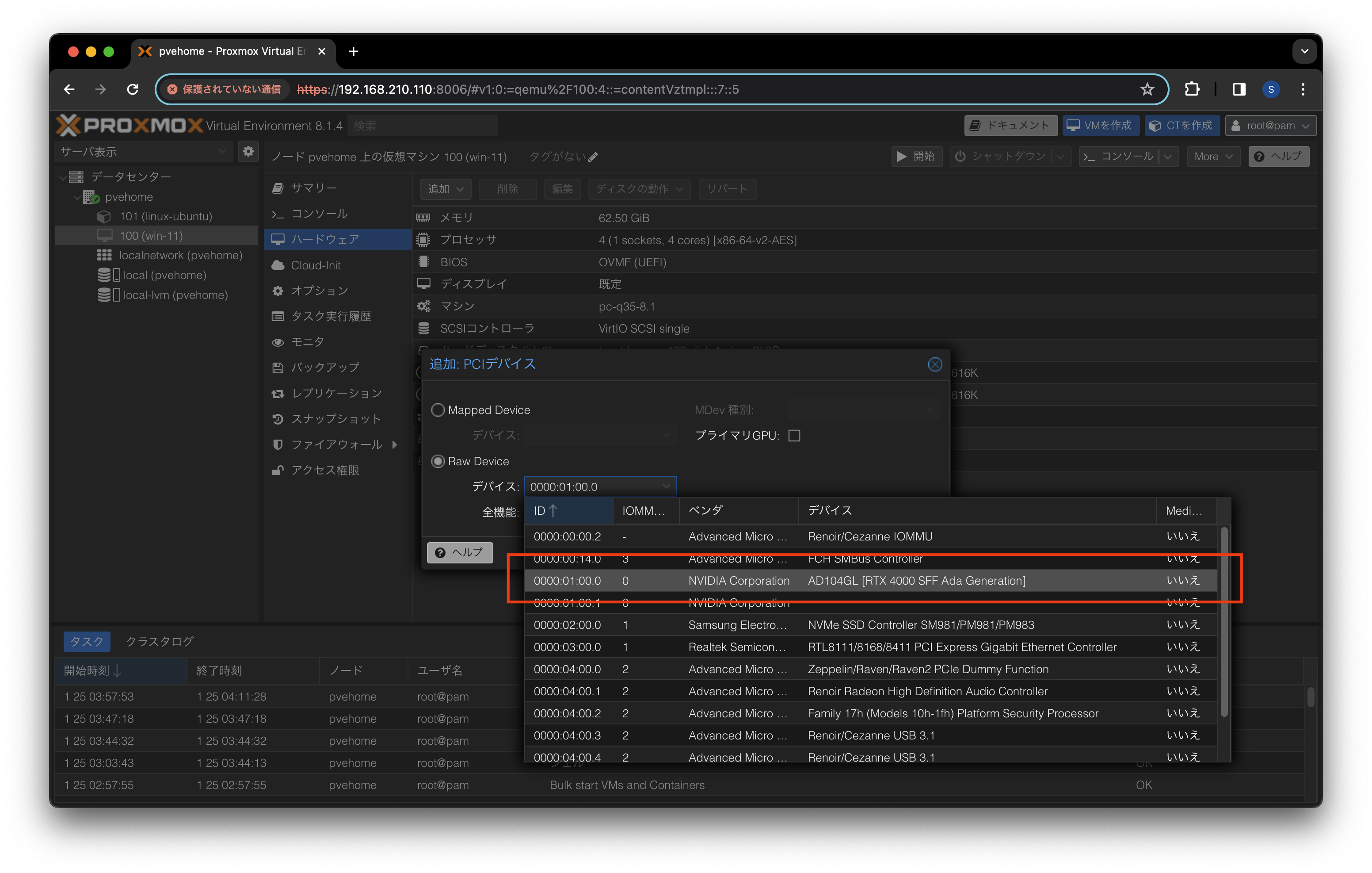

追加する PCI デバイスを設定し

追加ボタンを押下します。

- Raw Device

- デバイス: パススルーする GPU を選択します。

- 全機能: チェックを入れます。

- 詳細設定

- PCI-Express: チェックを入れます。

- Raw Device

-

ノード

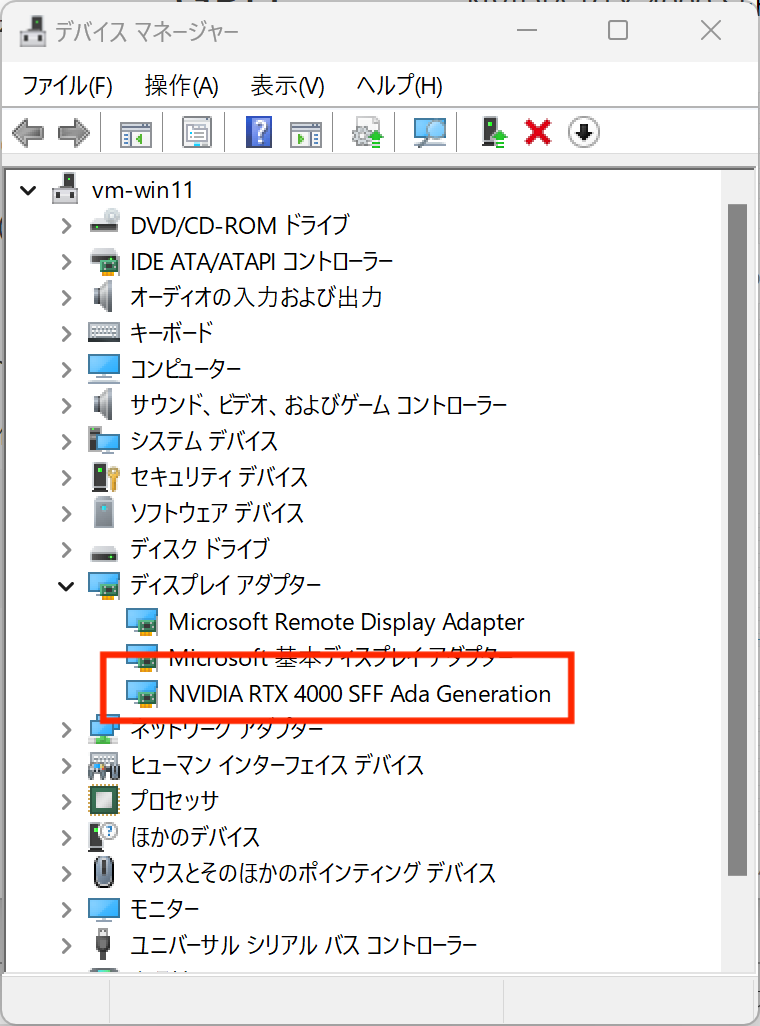

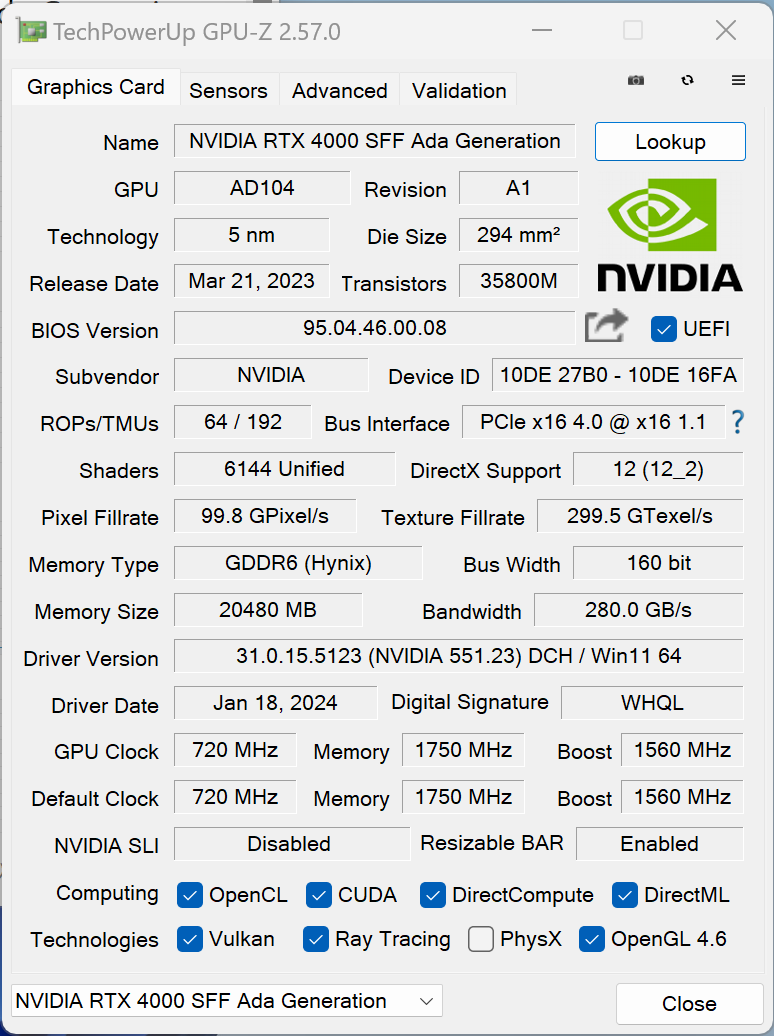

100 (win-11)を起動してリモートデスクトップ接続します。 -

GPU のドライバーをインストールして GPU を認識していることを確認します。

-

動作確認のために

サイバーパンク2077のベンチマークを実行します。

SSD を LXC 用ストレージとして使えるようにする手順

この手順は Proxmox ホストで実行してください。

Proxmox に SSD をマウント

-

SSD のデバイス名とファイルシステムを確認します。

lsblk -fこのコマンドで、どのデバイス(例:/dev/sda1 など)が SSD かを特定します。

それぞれの容量を確認するには:

lsblk -o NAME,SIZE,MODEL,ROTA -

SSD を ext4 でフォーマットします。

mkfs.ext4 /dev/sda1 -

SSD をマウントするディレクトリを作成します。

mkdir -p /mnt/sandisk_2tb_ssd_omv -

/etc/fstab に永続マウント設定を追加

echo "/dev/sda1 /mnt/sandisk_2tb_ssd_omv ext4 defaults 0 0" >> /etc/fstab -

実際にマウントします。

mount -a -

正常にマウントされたか確認します。

df -h | grep sda1

ストレージとして登録する

-

LXC コンテナ用ストレージとして登録します。

この設定を追加することで、LXC コンテナ作成時に omv をストレージとして選べるようになります。

/etc/pve/storage.cfgに下記を追記:dir: omv path /mnt/sandisk_2tb_ssd_omv content rootdir mkdir 0反映確認コマンド:

pvesm status

OMV のインストール手順

LXC コンテナのテンプレートは ubuntu-24.04-standard_24.04-2_amd64.tar.zst を使用します。

-

システムのアップデート

apt update && apt upgrade -y && apt autoremove -y -

OMV インストールスクリプトの実行

wget -O - https://github.com/OpenMediaVault-Plugin-Developers/installScript/raw/master/install | bash下記のエラーはインストール中に chrony(NTP 時刻同期サービス)の起動に失敗したことを示しています。 LXC コンテナでは systemd の一部機能が制限されており、chrony など一部のサービスが正しく起動できないことがあります。 OMV 自体のインストールは完了しています。

[ERROR ] Command '/usr/bin/systemd-run' failed with return code: 1 [ERROR ] stderr: Running scope as unit: run-r053eb19e7c79463bb1936ce2e5d83b0f.scope Job for chrony.service failed because the control process exited with error code. See "systemctl status chrony.service" and "journalctl -xeu chrony.service" for details. [ERROR ] retcode: 1 [ERROR ] Job for chrony.service failed because the control process exited with error code. -

Web UI にアクセスします。

http://<コンテナのIPアドレス>/ユーザー名: admin パスワード: openmediavault

-

ディレクトリマウントをコンテナにマウントします。

Proxmox CLI でディスクをバインドマウントする:

pct set <CTID> -mp0 /mnt/omv,mp=/mnt/omv- <CTID> は OMV LXC の ID(例: 100)

- /mnt/omv は Proxmox ホスト上の実ディレクトリ

- mp=/mnt/omv は LXC コンテナ内で見えるパス

設定後に LXC コンテナを再起動してください

-

OMV コンテナ内でディレクトリを作成します。 OMV の LXC にログインして以下を実行します:

mkdir -p /mnt/omv/share chown -R openmediavault:openmediavault /mnt/omv/share -

OMV で Samba 用ユーザーを作成

左メニューから「Access Rights Management → User」を開く

「Add」をクリック

任意のユーザー名(例: nasuser)

パスワードを設定

users グループに所属させる(デフォルト)

UID/GID を確認:

id nasuser -

Proxmox 側の /etc/fstab に反映

例:nasuser の UID が 1000, GID が 100 の場合

UUID=xxxx-xxxx /mnt/sandisk_2tb_ssd_omv ext4 defaults,uid=1000,gid=100 0 2ディレクトリの権限を変更:

chown -R 100000:100000 /mnt/sandisk_2tb_ssd_omv chown -R 100000:100000 /mnt/sandisk_2tb_ssd_omv/images chmod -R 770 /mnt/sandisk_2tb_ssd_omv/imagesOMV の LXC コンテナ内でマウントされているか、アクセスできるか確認:

ls -la /mnt/omv -

ファイルシステムとして「マウント」登録します。

OMV WebUI にログイン

左側メニューから Storage > File Systems に進む

上部メニューの「Mount」をクリック

表示されるパスに /mnt/omv が出てくるので選択

「Mount」ボタンで登録

Time Machine の設定手順

-

必要パッケージのインストール

sudo apt update sudo apt install samba avahi-daemon -y -

Time Machine 用のディレクトリ作成

sudo mkdir -p /srv/timemachine sudo chown nobody:nogroup /srv/timemachine sudo chown tmuser:tmuser /srv/timemachine sudo chmod 700 /srv/timemachine -

Samba ユーザーの作成(例: tmuser)

sudo adduser tmuser sudo smbpasswd -a tmuser -

/etc/samba/smb.conf の編集(Time Machine 対応設定を追加)

[timemachine] path = /srv/timemachine browseable = yes writable = yes create mask = 0777 directory mask = 0777 vfs objects = fruit fruit:time machine = yes fruit:advertise_fullsync = true fruit:model = Macmini valid users = tmuser -

サービスの再起動

sudo systemctl restart smbd sudo systemctl enable avahi-daemon